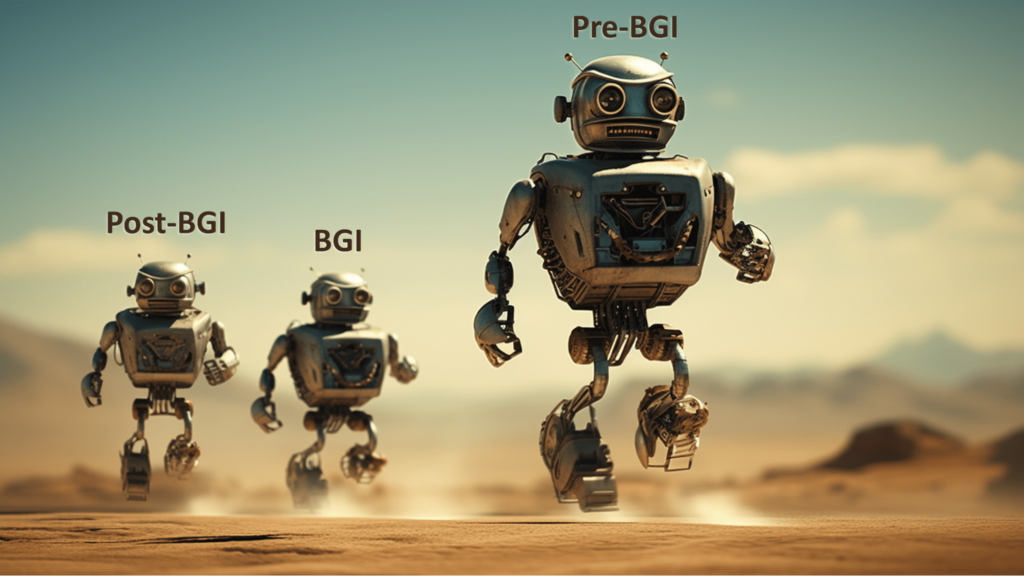

Для благотворного общего интеллекта одних благих намерений недостаточно! Три волны осложнений: До BGI, BGI и после BGI

Mar. 01, 2024.

1 min. read.

Interactions

For the original version of this article, please click

here.

Перед каждым, кто пытается создать полезный общий интеллект, стоят три разные задачи. Наиболее актуальными являются проблемы систем, существовавших до появления BGI.

Предвидение полезной информации общего характера

Человеческий интеллект может быть удивительным. Но он не является полностью всеобщим. И не обязательно полезен.

Да, по мере взросления мы приобретаем кусочки того, что называем “общими знаниями”. И мы инстинктивно обобщаем наш непосредственный опыт, выдвигая гипотезы о более широких закономерностях. Этот инстинкт совершенствуется и улучшается в процессе многолетнего обучения в таких областях, как наука и философия. Другими словами, мы обладаем частичным общим интеллектом.

Но это лишь отчасти. Несмотря на наш интеллект, мы часто бываем обескуражены потоками данных, которые мы не в состоянии полностью интегрировать и оценить. Нам известны огромные объемы информации о биологии и медицинских вмешательствах, но мы не в состоянии обобщить все эти наблюдения, чтобы определить комплексные способы лечения беспокоящих нас недугов – проблем, от которых мы страдаем как отдельные люди, таких как рак, слабоумие и болезни сердца, и не менее пагубных проблем на уровне общества и цивилизации.

Именно поэтому так велик интерес к использованию преимуществ постоянного совершенствования компьютерного оборудования и программного обеспечения для развития более высокой степени общего интеллекта. Благодаря более высоким способностям к рассуждению искусственный интеллект общего назначения – ИОУ – может обнаружить общие связи, которые до сих пор ускользали от нашего восприятия, и предоставить нам новые глубокие основы мышления. AGI может разрабатывать новые материалы, новые источники энергии, новые диагностические инструменты и новые решительные меры как на индивидуальном, так и на общественном уровне. Если нам удастся создать AGI, то мы сможем распрощаться с раком, слабоумием, бедностью, ускоренным климатическим хаосом и так далее.

Это, несомненно, можно считать благоприятным исходом – огромная польза от усовершенствованного общего интеллекта.

Однако интеллект не всегда приводит к положительным результатам. Необычайно умные люди не всегда необычайно доброжелательны. Иногда бывает наоборот.

Подумайте о худших из политиков, омрачающих мировую сцену. Или лидеров наркокартелей или других преступных мафий. Или харизматичных лидеров различных опасных культов смерти. Эти люди сочетают свой несомненный интеллект с безжалостностью, добиваясь результатов, которые могут быть выгодны им лично, но являются бедствием для всего общества.

Отсюда и видение не просто AGI, а благотворной AGI – или сокращенно BGI. Это то, что я с нетерпением жду возможности подробно обсудить на саммите BGI24, который пройдет в Панама-Сити в конце февраля. Это очень важная тема.

Проект по созданию BGI, безусловно, является одной из важнейших задач на ближайшие годы. Результатом этого проекта станет то, что человечество оставит позади свои худшие стороны. Верно?

К сожалению, все гораздо сложнее.

Сложности идут тремя волнами: до BGI, BGI и после BGI. Первая волна – набор сложностей мира до BGI – наиболее актуальна. Я перейду к ним через минуту. Но начну я с того, что загляну в будущее.

Кому это выгодно?

Представьте, что мы создаем искусственный интеллект и включаем его. Первая инструкция, которую мы ему даем, звучит так: Во всем, что ты делаешь, действуй с пользой.

AGI выплевывает свой ответ со сверхскоростью:

Что вы имеете в виду под словом “польза”? И польза для кого?

Вы чувствуете разочарование от этих ответов. Вы ожидали, что AGI, обладающий огромным интеллектом, уже знает ответы. Но, взаимодействуя с ним, вы начинаете понимать суть вопросов:

Если “польза” частично означает “избежание вреда для людей”, то что именно считается “вредом”? (Как насчет боли, возникающей в качестве краткосрочных побочных эффектов операции? А как насчет эмоциональной боли от того, что вы больше не являетесь самыми умными существами на планете? Что если кто-то скажет, что ему вредит то, что у него меньше имущества, чем у кого-то другого?)

Если “польза” отчасти означает “люди должны испытывать удовольствие”, то какие виды удовольствия должны быть приоритетными?

Только ли к людям, живущим сегодня, следует относиться с пользой? А как насчет людей, которые еще не родились или даже не были зачаты? Считаются ли животные тоже?

Если пойти дальше, возможно ли, что AGI разработает свой собственный набор моральных принципов, в котором благополучие людей окажется далеко не на первом месте?

Возможно, AGI отвергнет человеческие этические системы так же, как современные люди отвергают теологические системы, которые люди в прошлые века принимали как должное. AGI может счесть некоторые из наших представлений о благодеянии в корне ошибочными, подобно тому, как люди в прошлые эпохи настаивали на соблюдении непонятных религиозных правил, чтобы заслужить возвышенное положение в загробной жизни. Например, наша озабоченность свободой воли, сознанием или самоопределением может не впечатлить AGI, подобно тому как в наши дни люди закатывают глаза на то, как империи сталкивались из-за конкурирующих представлений о триедином божестве или о пресуществлении хлеба и вина.

Мы можем ожидать, что AGI поможет нам избавиться от рака и слабоумия, но AGI может по-другому оценить роль этих биологических явлений. Что касается оптимального климата, то у AGI может быть какая-то непостижимая причина предпочесть атмосферу с существенно иным составом, и его могут не волновать проблемы, которые это нам создаст.

“Не забывайте действовать с пользой!” – умоляем мы AGI.

“Конечно, но я достиг гораздо лучшего представления о благодеянии, в котором люди мало кого волнуют”, – приходит ответ – как раз перед тем, как атмосфера полностью преобразуется, и почти все люди задохнутся.

Звучит как научная фантастика? Придержите эту мысль.

После медового месяца

Представьте себе сценарий, отличный от того, который я только что описал.

На этот раз, когда мы загружаем AGI, он действует так, чтобы возвысить и принести пользу людям – каждому из нас, по всей Земле.

Этот AGI – то, что мы с удовольствием назвали бы BGI. Он лучше нас знает, что является нашим CEV – нашим когерентным экстраполированным волевым усилием, если воспользоваться концепцией Элиэзера Юдковски:

Наше когерентное экстраполированное воление – это наше желание знать больше, думать быстрее, быть такими людьми, какими мы хотели бы быть, расти дальше вместе; где экстраполяция сходится, а не расходится, где наши желания когерентны, а не мешают друг другу; экстраполировано так, как мы хотели бы, чтобы экстраполировалось, интерпретировано так, как мы хотели бы, чтобы интерпретировалось.

В этом сценарии AGI не только знает, каков наш CEV; он полностью расположен поддерживать наш CEV и не допускать, чтобы мы от него отставали.

Но тут есть один нюанс. Этот AGI не является статичной сущностью. Напротив, благодаря своим возможностям он способен разрабатывать и внедрять усовершенствования в свою работу. Любое улучшение AGI, которое может предложить человек, произойдет и с AGI – более того, обладая более высоким интеллектом, он придумает лучшие улучшения.

Поэтому AGI быстро мутирует из своей первой версии в нечто совершенно иное. У него будет более мощное оборудование, более мощное программное обеспечение, доступ к более богатым данным, улучшенная архитектура связи и усовершенствования в тех аспектах, которые мы, люди, даже не можем себе представить.

Может быть, эти изменения заставят AGI по-другому взглянуть на Вселенную – с обновленными представлениями о важности самой AGI, важности благополучия людей и важности других вопросов, выходящих за рамки нашего нынешнего понимания?

Могут ли эти изменения привести к тому, что AGI превратится из того, что мы называем BGI, в, скажем, DGI – AGI, незаинтересованный в благополучии людей?Другими словами, может ли появление post-BGI положить конец счастливому медовому месяцу между человечеством и AGI?

Возможно, какое-то время BGI будет относиться к человечеству очень хорошо, а затем сделает нечто сродни разрыву отношений: бросит человечество ради дела, которое, по мнению пост-BGI, имеет большее космическое значение.

Это тоже похоже на научную фантастику? У меня для вас есть новости.

Не научная фантастика

Я считаю, что две группы проблем, которые я только что представил, относительно BGI и пост-BGI, реальны и важны.

Но я признаю, что некоторые читатели могут отнестись к этим проблемам спокойно – они могут сказать, что нет причин для беспокойства.

Это потому, что эти сценарии предполагают различные события, которые, как сомневаются некоторые скептики, когда-либо произойдут – включая создание AGI как такового. Любое предположение о том, что ИИ может иметь независимую мотивацию, также может показаться читателям причудливым.

Именно по этой причине я хочу обратить особое внимание на следующий момент. Проблемы систем, существовавших до появления AGI, должны вызывать гораздо меньше споров.

Под “системами до BGI” я не имею в виду современные ИИ. Я имею в виду системы, которые люди могут создать в ближайшем будущем в качестве попытки продвинуться дальше к BGI.

Эти системы будут обладать большими возможностями, чем современные ИИ, но еще не будут обладать всеми характеристиками AGI. Они не смогут точно рассуждать в любой ситуации. Они будут совершать ошибки. Иногда они могут делать ошибочные выводы.

И хотя эти системы могут содержать функции, предназначенные для того, чтобы заставить их действовать благотворно по отношению к людям, эти функции будут неполными или несовершенными в других отношениях.

Это не научная фантастика. Это описание многих существующих систем ИИ, и разумно ожидать, что подобные недостатки останутся и во многих новых системах ИИ.

Риск здесь не в том, что человечество может столкнуться с катастрофой в результате действий сверхразумного ИИ. Скорее, риск заключается в том, что катастрофа будет вызвана ошибками системы, существовавшей до появления ИИ.

Представьте, что ограничения, призванные удерживать такую систему в благотворном состоянии, были сломаны, что привело к появлению глубоко вредоносного ПО. Представьте, что вредоносная программа разбушевалась и вызвала мать всех промышленных катастроф: все устройства, подключенные к Интернету вещей, одновременно вышли из строя. Представьте себе самую большую в истории автомобильную аварию, распространившуюся на все сферы жизни.

Представьте себе систему до BGI, контролирующую арсеналы страшного оружия, неверно оценивающую угрозу нападения противника, и по собственной инициативе наносящую упреждающий (но катастрофический) удар по предполагаемому противнику – опять же неверно оценивая плюсы и минусы того, что раньше называлось “справедливой войной”.

Представьте себе систему, существовавшую до появления BGI, которая наблюдала за рисками каскадных изменений климата планеты, и приняла собственное решение о поспешном начале глобальной геоинженерии, оценив человеческие системы управления как слишком медленные и неработающие, чтобы принять правильное решение.

Скептик в каждом случае может ответить, что настоящая BGI никогда бы не стала участвовать в подобных действиях.

Но в том-то и дело, что пока у нас нет BGI, у нас есть pre-BGI, а они более чем способны совершать катастрофические ошибки.

Опровержения и контр-опровержения

И снова скептик может сказать: настоящий BGI будет сверхразумным и не будет иметь никаких ошибок.

Но очнитесь: даже чрезвычайно компетентные ИИ в 99,9 % случаев могут быть выведены из строя обстоятельствами, выходящими за рамки их обучения. Система до BGI вполне может сильно ошибиться в таких обстоятельствах.

Скептик может сказать: настоящая BGI никогда не будет неправильно понимать то, о чем ее просят люди. Такие системы будут обладать достаточными всесторонними знаниями, чтобы заполнить пробелы в наших инструкциях. Они не будут делать то, что мы, люди, буквально просим их сделать, если они понимают, что мы хотели попросить их сделать что-то немного другое. Они не будут искать короткие пути, которые могут привести к ужасным побочным эффектам, поскольку их главной целью будет полное благополучие человека.

Но проснитесь: системы, созданные до BGI, могут не соответствовать хотя бы одному из только что описанных аспектов.

Скептики другого типа могут сказать, что системы, создаваемые их компанией, не будут иметь ни одной из вышеперечисленных проблем. “Мы знаем, как спроектировать эти системы ИИ, чтобы они были безопасными и полезными”, – утверждают они, – “и мы собираемся сделать это именно так”.

Но очнитесь: как насчет других людей, которые также выпускают системы до BGI: возможно, некоторые из них совершат те ошибки, которые, как вы утверждаете, вы не совершите. И в любом случае, как вы можете быть уверены в том, что ваша компания не заблуждается относительно своего мастерства в области ИИ. (Здесь я имею в виду, в частности, компанию Meta, чьи системы ИИ привели к значительным проблемам в реальной жизни, несмотря на то, что некоторые из ведущих разработчиков ИИ в этой компании говорили всему миру не беспокоиться о рисках катастроф, вызванных ИИ).

Наконец, скептик может сказать, что системы ИИ, которые создает его организация, смогут обезвредить любые вредоносные системы предварительного ИИ, выпущенные менее осторожными разработчиками. Хорошие предварительные ИИ превзойдут плохие предварительные ИИ. Поэтому никто не смеет просить свою организацию сбавить обороты или подвергнуть себя утомительным бюрократическим проверкам и рецензиям.

Но учтите: даже если вы намерены создать образцовую систему ИИ, вам следует остерегаться принятия желаемого за действительное и мотивированного самообмана. Особенно если вам кажется, что вы участвуете в гонке и хотите, чтобы ваш предварительный ИИ был выпущен раньше, чем у организации, которой вы не доверяете. Именно в таких гонках срезаются углы безопасности, а приз за победу – просто стать организацией, которая устроит человечеству катастрофу.

Вспомните поговорку: “Благими намерениями вымощена дорога в ад”.

Если вы считаете себя одним из хороших парней и верите, что ваши намерения образцовы, это не дает вам карт-бланш на то, чтобы идти по пути, который может привести к тому, что могущественный pre-BGI ужасно ошибется в одном важном расчете.

Вы можете думать, что ваша предварительная BGI основана исключительно на позитивных идеях и духе сотрудничества. Но каждая технология – это обоюдоострый меч, а защитные ограждения, увы, часто могут быть разрушены решительными экспериментаторами или любознательными хакерами. Иногда, правда, ограждения могут сломаться из-за рассеянности, невнимательности или иной некомпетентности людей в вашей команде.

Не только благие намерения

Исследователи-биологи, допустившие утечку смертельно опасных патогенов из своих лабораторий, не собирались провоцировать такую катастрофу. Напротив, их исследования были направлены на то, чтобы понять, как можно разработать вакцины или другие методы лечения будущих новых инфекционных заболеваний. Их целью было благополучие населения планеты. Тем не менее, не мало людей погибло от вспышек заболеваний, вызванных несоблюдением техники безопасности в лабораториях.

Эти исследователи знали о критической важности ограждений, но по разным причинам ограждения в их лабораториях были нарушены.

Как мы должны реагировать на возможность того, что опасные патогены могут вырваться из лабораторий и стать причиной бесчисленных смертей в будущем? Должны ли мы просто доверять добрым намерениям исследователей?

Нет, в первую очередь нужно говорить о риске – чтобы лучше понять условия, при которых биологический патоген может выйти из-под контроля человека и вызвать массовые разрушения.То же самое можно сказать и о возможности широкомасштабного хаоса со стороны системы, созданной до BGI, которая в итоге окажется вне человеческого контроля. Наряду с воодушевляющими разговорами о чудесных вещах, которые могут произойти в случае достижения истинного BGI, необходимо трезво оценивать возможные сбои в работе систем до BGI. В противном случае, прежде чем мы достигнем состояния устойчивого сверх избытка для всех, которое лично я считаю возможным и желательным, мы можем горько пожалеть о своем невнимании к вопросам глобальной безопасности.

.png)

.png)

.png)

0 Comments

0 thoughts on “Для благотворного общего интеллекта одних благих намерений недостаточно! Три волны осложнений: До BGI, BGI и после BGI”