Para lograr una Inteligencia General Beneficiosa, ¡las buenas intenciones no son suficientes! Tres Oleadas de Complicaciones: Pre-IGB, IGB y Post-IGB

Mar. 11, 2024.

14 min. read.

Interactions

For the original version of this article, please click

here.

Tres desafíos diferentes enfrenta cualquier persona que intenta construir una Inteligencia General Beneficiosa (IGB). Son los desafíos de los sistemas pre-IGB los más urgentes.

RELATED ARTICLES

Anticipando la Inteligencia General Beneficiosa

La inteligencia humana puede ser maravillosa. Sin embargo, no es completamente general, ni necesariamente beneficiosa.

Sí, a medida que crecemos, los seres humanos adquirimos fragmentos de lo que llamamos ‘conocimiento general’. E instintivamente generalizamos a partir de nuestras experiencias directas, formulando hipótesis sobre patrones más amplios. Ese instinto se perfecciona y mejora a lo largo de años de educación en campos como la ciencia y la filosofía. En otras palabras, lo que tenemos es una inteligencia parcialmente general.

Pero eso solo nos lleva hasta cierto punto. A pesar de nuestra inteligencia, a menudo nos sentimos desconcertados por el flujo abrumador de datos que no podemos integrar y evaluar completamente. Somos conscientes de enormes cantidades de información sobre biología e intervenciones médicas, pero no podemos generalizar a partir de todas estas observaciones para determinar curas integrales para los males que nos aquejan, problemas que nos afectan como individuos, como el cáncer, la demencia y las enfermedades cardíacas, y problemas igualmente perniciosos a niveles sociales y civilizacionales.

Esa es una de las razones por las que hay tanto interés en aprovechar las mejoras continuas en hardware y software de computadoras para desarrollar un mayor grado de inteligencia general. Con sus mayores poderes de razonamiento, la inteligencia artificial general, o IAG, podría discernir conexiones generales que hasta ahora han eludido nuestras percepciones y proporcionarnos marcos de pensamiento completamente nuevos. La IAG podría diseñar nuevos materiales, fuentes de energía, herramientas de diagnóstico y nuevas intervenciones decisivas tanto a nivel individual como societal. Si logramos desarrollar la IAG, entonces tendremos la perspectiva de decir adiós al cáncer, la demencia, la pobreza, el caos climático acelerado, y así sucesivamente. ¡Adiós y hasta pronto!

Eso seguramente se consideraría como resultados beneficiosos, un gran beneficio derivado de una inteligencia general mejorada.

Sin embargo, la inteligencia no siempre conduce a resultados beneficiosos. Las personas que son inusualmente inteligentes no siempre son inusualmente benevolentes. A veces es lo contrario.

Piensa en algunos de los peores políticos que oscurecen el escenario mundial. O los líderes de cárteles de drogas u otras mafias del crimen. O los líderes carismáticos de varios cultos de la muerte. Estas personas combinan su innegable inteligencia con crueldad, en la búsqueda de resultados que pueden beneficiarlos personalmente, pero que son plagas para la sociedad en general.

Por lo tanto, la visión no es solo de IAG, sino de IAG beneficiosa, o IGB en resumen. Eso es lo que espero discutir en detalle en la cumbre BGI24 que se llevará a cabo en la Ciudad de Panamá a finales de febrero. Es un tema de suma importancia.

El proyecto de construir IGB seguramente es una de las grandes tareas para los años venideros. El resultado de ese proyecto sería que la humanidad deje atrás nuestros peores aspectos. ¿Cierto?

Desafortunadamente, las cosas son más complicadas.

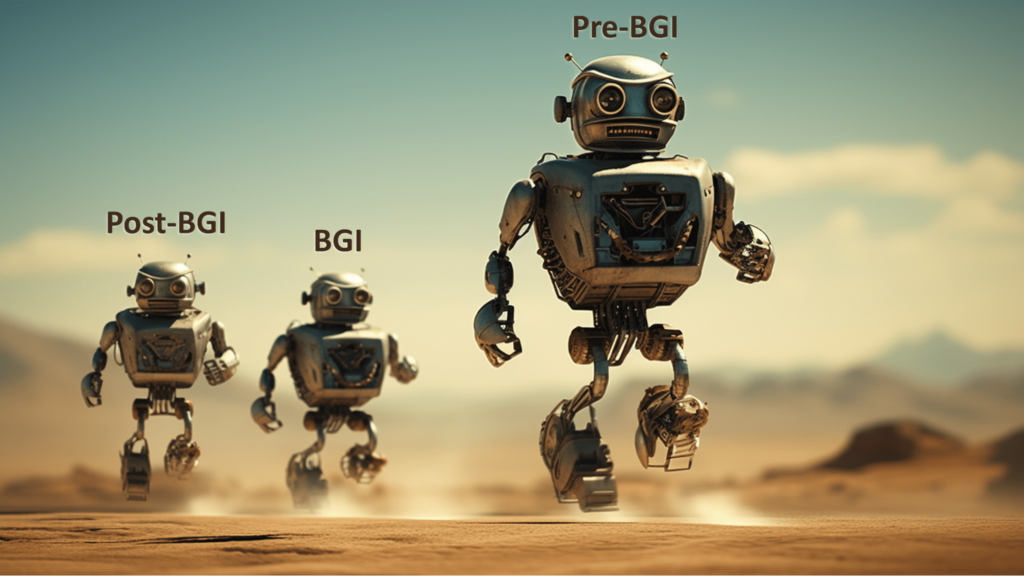

Las complicaciones se presentan en tres oleadas: pre-IGB, IGB y post-IGB. La primera oleada, el conjunto de complicaciones del mundo pre-IGB, es la más urgente. Me ocuparé de ellas en un momento, pero comenzaré mirando más hacia el futuro.

¿Beneficiosa para quién?

Imagina que creamos una IAG y la encendemos. La primera instrucción que le damos es: En todo lo que hagas, actúa de manera beneficiosa.

La IAG emite su respuesta a una velocidad hipersónica:

¿A qué te refieres con ‘beneficiosa’? Y ¿beneficiosa para quién?

Te sientes decepcionado por estas respuestas. Esperabas que la IAG, con su gran inteligencia, ya conociera las respuestas. Pero al interactuar con ella, comienzas a apreciar los problemas:

- Si ‘beneficiosa’ significa, en parte, ‘evitar que las personas sufran daño’, ¿qué cuenta exactamente como ‘daño’? (¿Y qué hay de los dolores que surgen como efectos secundarios a corto plazo de una cirugía? ¿Y el dolor emocional de ya no ser las entidades más inteligentes en el planeta? ¿Qué pasa si alguien dice que se siente perjudicado por tener menos posesiones que otra persona?)

- Si ‘beneficiosa’ significa, en parte, ‘las personas deben experimentar placer’, ¿qué tipos de placeres deberían tener prioridad?

- ¿Solo las personas que viven hoy deberían ser tratadas de manera beneficiosa? ¿Qué pasa con las personas que aún no han nacido o que ni siquiera han sido concebidas? ¿Se cuentan también los animales?

Yendo más lejos, ¿es posible que la IAG pueda idear su propio conjunto de principios morales, en el cual el bienestar de los humanos ocupe un lugar muy bajo en su conjunto de prioridades?

Quizás la IAG rechace los sistemas éticos humanos de la misma manera en que los humanos modernos rechazan los sistemas teológicos que la gente en siglos anteriores daba por sentado. La IAG podría considerar que algunas de nuestras nociones de beneficencia son fundamentalmente equivocadas, de la misma manera en que las personas en eras pasadas insistían en reglas religiosas oscuras para ganarse una posición elevada en una vida después de la muerte. Por ejemplo, nuestras preocupaciones sobre el libre albedrío, la conciencia o la autodeterminación podrían serles indiferentes a una IAG, así como la gente hoy en día rodaría los ojos ante cómo algunos imperios cayeron por concepciones en competencia de una divina trinidad o la transustanciación del pan y el vino.

Podemos esperar que la IAG nos ayude a liberar nuestros cuerpos de cáncer y demencia, pero la IAG podría hacer una evaluación diferente del papel de estos fenómenos biológicos. En cuanto a un clima óptimo, la IAG podría tener alguna razón incomprensible para preferir una atmósfera con una composición significativamente diferente, y podría no preocuparse por los problemas que eso nos causaría.

“No olvides actuar de manera beneficiosa”, imploramos a la IAG.

“Claro, pero he llegado a una noción mucho mejor de beneficencia, en la cual los humanos son de poca preocupación”, llega la respuesta, justo antes de que la atmósfera sea transformada por completo y casi todos los humanos se asfixien.

¿Suena como ciencia ficción? Mantén ese pensamiento.

Después de la luna de miel

Imagina un escenario diferente al que acabo de describir.

Esta vez, cuando iniciamos la IAG, actúa de maneras que elevan y benefician a los humanos, a cada uno de nosotros, en todo el mundo.

Esta IAG es lo que estaríamos encantados de describir como una IGB. Conoce mejor que nosotros cuál es nuestro VEC, nuestra voluntad extrapolada coherente, para usar un concepto de Eliezer Yudkowsky:

Nuestra voluntad extrapolada coherente es nuestro deseo si supiéramos más, pensáramos más rápido, fuéramos más las personas que deseamos ser, hubiéramos crecido más juntos; donde la extrapolación converge en lugar de divergir, donde nuestros deseos son coherentes en lugar de interferir; extrapolada como deseamos que se extrapolara, interpretada como deseamos que se interpretara.

En este escenario, no solo la IAG sabe cuál es nuestro VEC; está completamente dispuesta a respaldar nuestro VEC y evitar que nos quedemos cortos.

Pero hay un giro. Esta IAG no es una entidad estática. En cambio, como resultado de sus capacidades, es capaz de diseñar e implementar mejoras en cómo opera. Cualquier mejora en la IAG que un humano pueda sugerir también se le habrá ocurrido a la IAG, de hecho, al tener una inteligencia superior, propondrá mejoras aún mejores.

Por lo tanto, la IAG muta rápidamente desde su primera versión a algo completamente diferente. Tiene hardware más potente, software más avanzado, acceso a datos más ricos, una arquitectura de comunicaciones mejorada y mejoras en aspectos que nosotros, los humanos, ni siquiera podemos concebir.

¿Podrían estos cambios hacer que la IAG vea el universo de manera diferente, con ideas actualizadas sobre la importancia de la propia IAG, la importancia del bienestar de los humanos y la importancia de otros asuntos más allá de nuestra comprensión actual?

¿Podrían estos cambios hacer que la IAG transicione de ser lo que llamamos una IGB a, digamos, una IGD, una IGA desinteresada en el bienestar humano?

En otras palabras, ¿podría la aparición de una pos-IGB poner fin a la feliz luna de miel entre la humanidad y la IAG?

Quizás la IGB trate a la humanidad muy bien durante un tiempo, antes de hacer algo parecido a superar una relación: dejar a la humanidad por una causa que la entidad pos-IGB considere de mayor importancia cósmica.

¿Esto también suena como ciencia ficción? Tengo noticias para ti.

No es ciencia ficción

Mi propia opinión es que los dos conjuntos de desafíos que acabo de presentar, respecto a la IGB y pos-IGB, son reales e importantes.

Pero reconozco que algunos lectores pueden estar tranquilos acerca de estos desafíos y decir que no hay razón para preocuparse. Esto se debe a que estos escenarios asumen varios desarrollos que algunos escépticos dudan que ocurran alguna vez, incluida la creación de la IAG misma. Cualquier sugerencia de que una inteligencia artificial pueda tener motivación independiente también puede parecerle a los lectores algo fantasioso.

Es por eso que quiero resaltar de manera contundente el siguiente punto. Los desafíos de los sistemas pre-IGB deberían ser mucho menos controvertidos.

Cuando me refiero a un “sistema pre-IGB”, no me refiero particularmente a las IAs actuales. Me refiero a sistemas que las personas puedan crear, en un futuro cercano, como intentos de avanzar hacia la IGB.

Estos sistemas tendrán mayores capacidades que las IA actuales, pero aún no tendrán todas las características de la IAG. No podrán razonar con precisión en todas las situaciones. Cometerán errores. En ocasiones, pueden llegar a conclusiones incorrectas.

Y aunque estos sistemas pueden contener características diseñadas para hacer que actúen de manera beneficiosa hacia los humanos, estas características serán incompletas o defectuosas de otras maneras.

Eso no es ciencia ficción. Es una descripción de muchos sistemas de IA existentes, y es razonable esperar que fallos similares persistan en muchos nuevos sistemas de IA.

El riesgo aquí no es que la humanidad pueda experimentar una catástrofe como resultado de las acciones de una IAG superinteligente. Más bien, el riesgo es que una catástrofe sea causada por un sistema pre-IGB fallado.

Imagina que las restricciones diseñadas para mantener a ese sistema en una mentalidad beneficiosa fueran vulneradas, liberando un malware extremadamente perjudicial. Imagina que ese malware se desata y provoca la madre de todas las catástrofes industriales: haciendo que todos los dispositivos conectados a Internet de las Cosas fallen simultáneamente. Piensa en la peor colisión de automóviles jamás vista, extendida a todos los ámbitos de la vida.

Imagina un sistema pre-IGB supervisando temibles arsenales de armas, calculando erróneamente la amenaza de un ataque enemigo y tomando la iniciativa de golpear preventivamente (pero desastrosamente) contra un adversario percibido, equivocándose (nuevamente) en los pros y contras de lo que solía llamarse ‘una guerra justa’.

Imagina un sistema pre-IGB observando los riesgos de cambios en cascada en el clima mundial y tomando su propia decisión de iniciar una geoingeniería global apresurada, evaluando los sistemas de gobernanza humana como demasiado lentos y disfuncionales para tomar la decisión correcta.

Un escéptico podría responder, en cada caso, que una verdadera IGB nunca participaría en tal acción.

Pero ese es el punto: antes de tener IGBs, tendremos sistemas pre-IGB, que serán más que capaces de cometer errores desastrosos.

Refutaciones y contra refutaciones

De nuevo, un escéptico podría decir: una verdadera IGB será superinteligente y no tendrá errores.

Pero despierta: incluso las IAs extremadamente competentes el 99,9% del tiempo pueden desordenarse por circunstancias más allá de su conjunto de entrenamiento. Un sistema pre-IGB bien podría salir mal en tales circunstancias.

Un escéptico podría decir: una verdadera IGB nunca malinterpretará lo que los humanos le pidan hacer. Estos sistemas tendrán conocimientos completos para llenar los vacíos en nuestras instrucciones. No harán exactamente lo que los humanos les pidan hacer si entienden que queríamos pedirles que hicieran algo ligeramente diferente. No buscarán atajos con efectos secundarios terribles, ya que tendrán el bienestar humano completo como su objetivo principal.

Pero despierten: los sistemas pre-IGB pueden quedarse cortos en al menos uno de los aspectos recién descritos.

Un tipo diferente de escéptico podría decir que los sistemas pre-IGB que su empresa está creando no tendrán ninguno de los problemas mencionados anteriormente. “Sabemos cómo diseñar estos sistemas de IA para que sean seguros y beneficiosos”, afirman, “y lo haremos de esa manera”.

Pero despierten: ¿qué hay de otras personas que también están lanzando sistemas pre-IGB? Tal vez algunos de ellos cometan los tipos de errores que ustedes dicen que no cometerán. Y, en cualquier caso, ¿cómo pueden estar tan seguros de que su empresa no está engañándose a sí misma sobre su destreza en IA? (Aquí, estoy pensando especialmente en Meta, cuyos sistemas de IA han causado problemas significativos en la vida real, a pesar de que algunos de los principales desarrolladores de IA en esa empresa le dicen al mundo que no se preocupe por los riesgos de una catástrofe inducida por la IA).

Finalmente, un escéptico podría decir que los sistemas de IA que su organización está creando podrán desarmar cualquier sistema pre-IAG maligno lanzado por desarrolladores menos cuidadosos. Los buenos sistemas pre-IGB superarán a los malos pre-IAG. Por lo tanto, nadie debería atreverse a pedirle a su organización que se ralentice o se someta a molestas verificaciones y revisiones burocráticas.

Pero despierten: aunque sea su intención crear un sistema de IA ejemplar, deben tener cuidado con la autosugestión y el autoengaño motivado. Especialmente si perciben que están en una carrera y desean lanzar su sistema pre-IGB antes que una organización en la que desconfían. Ese es el tipo de carrera donde se recortan las esquinas de seguridad, y el premio por ganar es simplemente ser la organización que inflige una catástrofe a la humanidad.

Recuerden el dicho: “El camino al infierno está empedrado de buenas intenciones”.

Solo porque te consideres uno de los buenos y creas que tus intenciones son ejemplares, eso no te da carta blanca para seguir un camino que podría llevar a que un poderoso sistema pre-IGB cometa un cálculo crucial de manera horriblemente incorrecta.

Puedes pensar que tu sistema pre-IGB se basa completamente en ideas positivas y un espíritu colaborativo. Pero cada pieza de tecnología es una espada de doble filo, y lamentablemente, las barandillas de protección a menudo pueden ser desmanteladas por experimentadores determinados o hackers curiosos. A veces, de hecho, las barandillas pueden romperse debido a que personas en tu equipo estén distraídas, descuidadas o sean incompetentes de alguna otra manera.

Más allá de las buenas intenciones

Los investigadores de biología responsables de permitir fugas de patógenos mortales desde sus laboratorios no tenían la intención de causar tal desastre. Por el contrario, la motivación detrás de su investigación era comprender cómo podrían desarrollarse vacunas u otros tratamientos en respuesta a futuras enfermedades infecciosas. Lo que imaginaban era el bienestar de la población mundial. Sin embargo, números desconocidos de personas murieron a raíz de brotes resultantes de la implementación deficiente de procesos de seguridad en sus laboratorios.

Estos investigadores conocían la importancia crítica de las barandillas de protección, pero por diversas razones, las barandillas en sus laboratorios fueron violadas.

¿Cómo debemos responder a la posibilidad de que patógenos peligrosos escapen de laboratorios y causen innumerables muertes en el futuro? ¿Debemos confiar sólo en las buenas intenciones de los investigadores involucrados?

No, la primera respuesta debería ser hablar sobre el riesgo, llegar a una mejor comprensión de las condiciones bajo las cuales un patógeno biológico puede evadir el control humano y causar estragos generalizados.

Es lo mismo con la posibilidad de estragos generalizados a partir de un sistema pre-IGB que termine operando fuera del control humano. Junto con cualquier discurso inspirador sobre las cosas maravillosas que podrían suceder si se logra una verdadera IGB, debe haber una discusión serena sobre las posibles fallas de los sistemas pre-IGB. De lo contrario, antes de llegar al estado de superabundancia sostenible para todos, que personalmente veo como posible y deseable, podríamos lamentar amargamente nuestra falta de atención a los asuntos de seguridad global.

.png)

.png)

.png)

0 Comments

0 thoughts on “Para lograr una Inteligencia General Beneficiosa, ¡las buenas intenciones no son suficientes! Tres Oleadas de Complicaciones: Pre-IGB, IGB y Post-IGB”