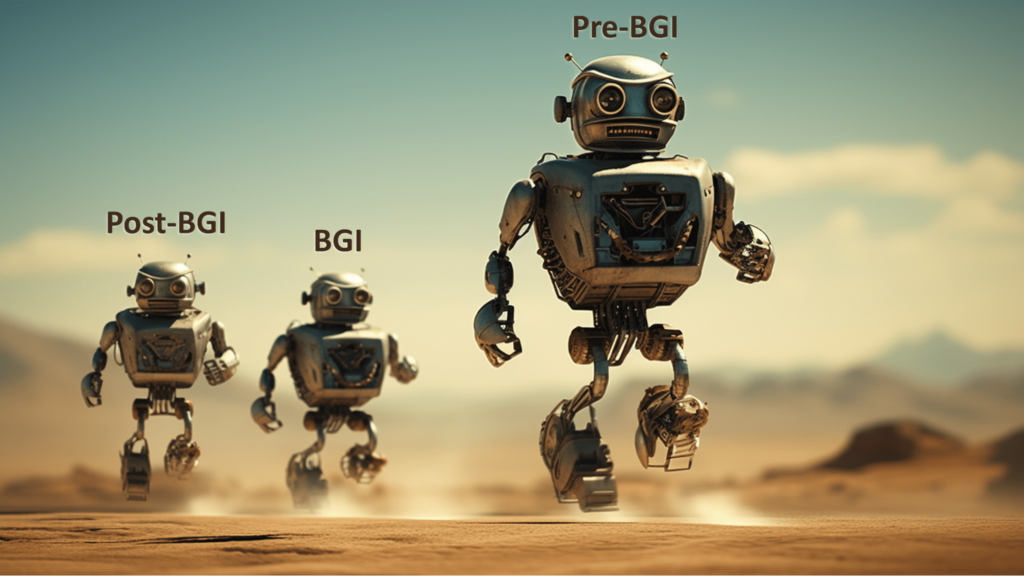

Para uma inteligência geral benéfica, as boas intenções não são suficientes! Três ondas de complicações: Pré-BGI, BGI e Pós-BGI

Mar. 11, 2024. 15 mins. read.

Interactions

For the original version of this article, please click

here.

Três desafios diferentes enfrentam qualquer pessoa que tente construir uma Inteligência Geral Benéfica. São os desafios dos sistemas pré-BGI que são mais urgentes.

Antecipar a inteligência geral benéfica

A inteligência humana pode ser maravilhosa. Mas não é totalmente geral. Nem é necessariamente benéfica.

Sim, à medida que crescemos, nós, humanos, adquirimos pedaços daquilo a que chamamos “conhecimento geral”. E, instintivamente, generalizamos a partir das nossas experiências directas, criando hipóteses de padrões mais amplos. Esse instinto é refinado e melhorado através de anos de educação em domínios como a ciência e a filosofia. Por outras palavras, temos uma inteligência geral parcial.

Mas isso só nos leva até certo ponto. Apesar da nossa inteligência, ficamos muitas vezes perplexos com os fluxos de dados que não conseguimos integrar e avaliar completamente. Temos conhecimento de enormes quantidades de informação sobre biologia e intervenções médicas, mas somos incapazes de generalizar a partir de todas estas observações para determinar curas abrangentes para as doenças que nos perturbam – problemas que nos afligem como indivíduos, como o cancro, a demência e as doenças cardíacas, e problemas igualmente perniciosos a nível social e civilizacional.

Esta é uma das razões pelas quais há tanto interesse em tirar partido das melhorias em curso no hardware e software informáticos para desenvolver um grau mais elevado de inteligência geral. Com os seus maiores poderes de raciocínio, a inteligência geral artificial – AGI – pode discernir ligações gerais que até agora escaparam às nossas percepções e fornecer-nos novas e profundas estruturas de pensamento. A AGI poderá conceber novos materiais, novas fontes de energia, novos instrumentos de diagnóstico e novas intervenções decisivas, tanto a nível individual como social. Se conseguirmos desenvolver a AGI, teremos a perspetiva de dizer adeus ao cancro, à demência, à pobreza, ao caos climático acelerado, etc. Adeus e boa viagem!

Isto contaria certamente como resultados benéficos – um grande benefício de uma inteligência geral melhorada.

No entanto, a inteligência nem sempre conduz a resultados benéficos. As pessoas que são invulgarmente inteligentes nem sempre são invulgarmente benevolentes. Por vezes, é o contrário.

Consideremos alguns dos piores políticos que ocupam os palcos do mundo. Ou os líderes de cartéis de droga ou de outras máfias criminosas. Ou os líderes carismáticos de vários cultos de morte perigosos. Estas pessoas combinam a sua indubitável inteligência com a impiedade, em busca de resultados que podem beneficiá-las pessoalmente, mas que são um flagelo para a sociedade em geral.

Daí a visão, não apenas da AGI, mas da AGI benéfica – ou BGI, abreviadamente. É isso que espero discutir longamente na cimeira BGI24, que terá lugar na Cidade do Panamá no final de fevereiro. Trata-se de um tema extremamente importante.

O projeto de construção do BGI é seguramente uma das grandes tarefas para os próximos anos. O resultado desse projeto será a humanidade deixar para trás os seus piores aspectos. Não é verdade?

Infelizmente, as coisas são mais complicadas.

As complicações surgem em três vagas: pré-BGI, BGI e pós-BGI. A primeira vaga – o conjunto de complicações do mundo pré-BGI – é a mais urgente. Falarei delas num instante. Mas começarei por olhar mais para o futuro.

Benéfico para quem?

Imaginemos que criamos um AGI e o ligamos. A primeira instrução que lhe damos é: Em tudo o que fizeres, age de forma benéfica.

O AGI dá a sua resposta a grande velocidade:

O que é que quer dizer com “benéfico”? E benéfico para quem?

Sente-se desiludido com estas respostas. Esperavas que o AGI, com a sua grande inteligência, já soubesse as respostas. Mas à medida que interage com ela, começa a apreciar as questões:

- Se “benéfico” significa, em parte, “evitar que as pessoas sofram danos”, o que é que conta exatamente como “dano”? (E as dores que surgem como efeitos secundários a curto prazo de uma cirurgia? E a dor emocional de deixar de ser a entidade mais inteligente do planeta? E se alguém disser que é prejudicado por ter menos posses do que outra pessoa?)

- Se “benéfico” significa, em parte, “as pessoas devem sentir prazer”, a que tipos de prazeres deve ser dada prioridade?

- Serão apenas as pessoas que vivem atualmente que devem ser tratadas de forma benéfica? E as pessoas que ainda não nasceram ou que ainda nem sequer foram concebidas? Os animais também são contabilizados?

Indo mais longe, será possível que a AGI possa conceber o seu próprio conjunto de princípios morais, em que o bem-estar dos seres humanos esteja muito abaixo no seu conjunto de prioridades?

Talvez a AGI rejeite os sistemas éticos humanos da mesma forma que os humanos modernos rejeitam os sistemas teológicos que as pessoas dos séculos anteriores tomaram como garantidos. O AGI pode considerar algumas das nossas noções de beneficência como fundamentalmente mal orientadas, tal como as pessoas em épocas passadas insistiam em regras religiosas obscuras para ganharem uma posição elevada numa vida após a morte. Por exemplo, as nossas preocupações com o livre-arbítrio, a consciência ou a autodeterminação podem deixar um AGI pouco impressionado, tal como as pessoas hoje em dia reviram os olhos ao verem como os impérios entraram em conflito por causa de concepções concorrentes de uma divindade trina ou da transubstanciação do pão e do vinho.

Podemos esperar que a AGI nos ajude a livrar o nosso corpo do cancro e da demência, mas a AGI pode fazer uma avaliação diferente do papel destes fenómenos biológicos. Quanto ao clima ótimo, o AGI pode ter alguma razão insondável para preferir uma atmosfera com uma composição significativamente diferente e pode não se preocupar com os problemas que isso nos causaria.

“Não te esqueças de agir de forma benéfica!”, imploramos ao AGI.

“Claro, mas eu alcancei uma noção muito melhor de beneficência, na qual os humanos não são uma preocupação”, vem a resposta – mesmo antes de a atmosfera se transformar completamente e quase todos os humanos serem asfixiados.

Isto soa a ficção científica? Não penses mais nisso.

Depois da lua de mel

Imaginemos um cenário diferente do que acabámos de descrever.

Desta vez, quando arrancamos com a AGI, ela actua de forma a elevar e beneficiar os seres humanos – todos e cada um de nós, em toda a Terra.

Este AGI é o que gostaríamos de descrever como um BGI. Sabe melhor do que nós o que é o nosso CEV – a nossa volição extrapolada coerente, para usar um conceito de Eliezer Yudkowsky:

A nossa volição extrapolada coerente é o nosso desejo de saber mais, de pensar mais depressa, de sermos mais as pessoas que desejávamos ser, de termos crescido mais juntos; onde a extrapolação converge em vez de divergir, onde os nossos desejos se coadunam em vez de interferir; extrapolados como desejamos que sejam extrapolados, interpretados como desejamos que sejam interpretados.

Neste cenário, o AGI não só sabe qual é o nosso CEV, como está inteiramente disposto a apoiar o nosso CEV e a evitar que fiquemos aquém dele.

Mas há uma reviravolta. Este AGI não é uma entidade estática. Em vez disso, como resultado das suas capacidades, é capaz de conceber e implementar actualizações no seu modo de funcionamento. Qualquer melhoramento que um humano possa sugerir à AGI terá ocorrido também à AGI – de facto, tendo uma inteligência superior, ela apresentará melhores melhoramentos.

Assim, a AGI transforma-se rapidamente da sua primeira versão em algo muito diferente. Tem um hardware mais potente, um software mais potente, acesso a dados mais ricos, uma arquitetura de comunicações melhorada e melhorias em aspectos que nós, humanos, nem sequer conseguimos conceber.

Poderão estas mudanças fazer com que o AGI veja o universo de forma diferente – com ideias actualizadas sobre a importância do próprio AGI, a importância do bem-estar dos humanos e a importância de outros assuntos para além da nossa compreensão atual?

Poderão estas mudanças fazer com que o AGI passe daquilo a que chamamos um BGI para, digamos, um DGI – um AGI que não se interessa pelo bem-estar humano?

Por outras palavras, poderá o aparecimento de um pós-BGI acabar com a feliz lua de mel entre a humanidade e o AGI?

Talvez o BIG, durante algum tempo, trate a humanidade muito bem, antes de fazer algo semelhante a sair de uma relação: deixar a humanidade por uma causa que a entidade pós-BIG considere ter maior significado cósmico.

Isto também soa ficção científica? Tenho novidades para si.

Não é ficção científica

A minha opinião é que os dois conjuntos de desafios que acabei de apresentar – relativamente ao BGI e ao pós-BGI – são reais e importantes.

Mas reconheço que alguns leitores podem estar tranquilos em relação a estes desafios – podem dizer que não há necessidade de se preocuparem.

Isto porque estes cenários pressupõem vários desenvolvimentos que alguns cépticos duvidam que venham a acontecer – incluindo a criação da própria AGI. Qualquer sugestão de que uma IA possa ter uma motivação independente pode também parecer fantasiosa para os leitores.

É por essa razão que quero destacar o ponto seguinte. Os desafios dos sistemas pré-BGI devem ser muito menos controversos.

Por “sistema pré-BGI” não me refiro particularmente às IAs actuais. Estou a referir-me aos sistemas que as pessoas podem criar, num futuro próximo, como tentativas de avançar em direção à BGI.

Estes sistemas terão mais capacidades do que as actuais IAs, mas não terão ainda todas as características da AGI. Não serão capazes de raciocinar com exatidão em todas as situações. Cometerão erros. Ocasionalmente, poderão chegar a conclusões erróneas.

E, embora estes sistemas possam conter características concebidas para os fazer agir de forma benéfica para os seres humanos, essas características serão incompletas ou defeituosas noutros aspectos.

Isto não é ficção científica. É uma descrição de muitos dos actuais sistemas de IA, e é razoável esperar que falhas semelhantes se mantenham em muitos dos novos sistemas de IA.

O risco aqui não é que a humanidade possa sofrer uma catástrofe em resultado das acções de um AGI superinteligente. Pelo contrário, o risco é que a catástrofe seja causada por um sistema pré-BGI com erros.

Imaginemos que as restrições destinadas a manter esse sistema numa mentalidade benéfica são quebradas, libertando um malware profundamente desagradável. Imaginemos que esse malware se descontrola e provoca a mãe de todas as catástrofes industriais: faz com que todos os dispositivos ligados à Internet das Coisas funcionem mal em simultâneo. Pense no maior acidente de automóvel de sempre, alargado a todos os domínios da vida.

Imagine-se um sistema pré-BGI a supervisionar arsenais de armas temíveis, a calcular mal a ameaça de um ataque inimigo e a tomar a sua própria iniciativa de atacar preventivamente (mas de forma desastrosa) um adversário que se julga ser o mais forte – calculando mal (mais uma vez) os prós e os contras daquilo a que se costumava chamar “uma guerra justa”.

Imaginemos um sistema pré-BGI que observa os riscos de alterações em cascata no clima mundial e toma a sua própria decisão de iniciar uma geo-engenharia global apressada – por avaliar que os sistemas de governação humana são demasiado lentos e disfuncionais para tomar a decisão certa.

Um cético poderia responder, em cada caso, que um verdadeiro BGI nunca se envolveria em tal ação.

Mas esse é o ponto: antes de termos BGIs, teremos pré-BGIs, e eles são mais do que capazes de cometer erros desastrosos.

Refutações e contra-refutações

Mais uma vez, um cético poderá dizer: uma verdadeira BGI será superinteligente e não terá quaisquer bugs.

Mas atenção: mesmo as IAs que são extremamente competentes em 99,9% das vezes podem ser desorganizadas por circunstâncias que ultrapassam o seu conjunto de treino. Um sistema pré-BGI pode muito bem correr mal numa circunstância dessas.

Um cético poderá dizer: uma verdadeira BGI nunca interpretará mal o que os humanos lhe pedem para fazer. Esses sistemas terão conhecimentos gerais suficientes para preencher as lacunas das nossas instruções. Não farão o que nós, humanos, lhes pedimos literalmente para fazer, se perceberem que queríamos pedir-lhes para fazer algo ligeiramente diferente. Não procurarão atalhos que tenham efeitos secundários terríveis, uma vez que o seu objetivo principal será o bem-estar humano.

Mas atenção: os sistemas pré-BGI podem ficar aquém em pelo menos um dos aspectos que acabámos de descrever.

Um tipo diferente de cético pode dizer que os sistemas pré-BGI que a sua empresa está a criar não terão nenhum dos problemas acima referidos. “Sabemos como conceber estes sistemas de IA para serem seguros e benéficos”, afirmam, “e vamos fazê-lo dessa forma”.

Mas acordem: e as outras pessoas que também estão a lançar sistemas pré-BGI: talvez algumas delas cometam os tipos de erros que vocês afirmam que não vão cometer. E, em qualquer caso, como é que pode estar tão confiante de que a sua empresa não se está a iludir sobre a sua proeza em IA? (Aqui, estou a pensar particularmente na Meta, cujos sistemas de IA causaram problemas significativos na vida real, apesar de alguns dos principais criadores de IA dessa empresa terem dito ao mundo para não se preocuparem com os riscos de catástrofe induzida pela IA).

Por último, um cético poderá dizer que os sistemas de IA que a sua organização está a criar serão capazes de desarmar quaisquer sistemas pré-BGI malignos lançados por programadores menos cuidadosos. As boas pré-BGIs serão mais eficazes do que as más pré-BGIs. Por conseguinte, ninguém se deve atrever a pedir à sua organização que abrande ou que se submeta a controlos e revisões burocráticas cansativas.

Mas atenção: mesmo que a sua intenção seja criar um sistema de IA exemplar, tem de ter cuidado com o pensamento positivo e o auto-engano motivado. Especialmente se tiver a perceção de que está numa corrida e quiser que o seu pré-BGI seja lançado antes do de uma organização de que desconfia. Esse é o tipo de corrida em que se cortam os cantos à segurança e o prémio para ganhar é simplesmente ser a organização que inflige uma catástrofe à humanidade.

Lembrem-se do ditado: “O caminho para o inferno está cheio de boas intenções”.

Só porque se considera um dos bons da fita e acredita que as suas intenções são exemplares, isso não lhe dá carta branca para prosseguir por um caminho que pode levar a que um poderoso pré-BGI faça um cálculo crucial terrivelmente errado.

Pode pensar que o seu pré-IGB se baseia inteiramente em ideias positivas e num espírito de colaboração. Mas cada peça de tecnologia é uma faca de dois gumes e as barreiras de proteção podem, infelizmente, ser muitas vezes desmanteladas por experimentadores determinados ou hackers curiosos. Por vezes, de facto, as barreiras de proteção podem quebrar-se devido à distração, descuido ou incompetência das pessoas da sua equipa.

Para além das boas intenções

Os investigadores biológicos responsáveis pelas fugas de agentes patogénicos mortais dos seus laboratórios não tinham qualquer intenção de provocar uma tal catástrofe. Pelo contrário, a motivação subjacente à sua investigação era compreender como poderiam ser desenvolvidas vacinas ou outros tratamentos em resposta a futuras novas doenças infecciosas. O que eles visavam era o bem-estar da população mundial. No entanto, um número desconhecido de pessoas morreu devido a surtos resultantes da má implementação de processos de segurança nos seus laboratórios.

Estes investigadores sabiam da importância crucial das barreiras de proteção, mas por várias razões, as barreiras de proteção nos seus laboratórios foram violadas.

Como devemos reagir à possibilidade de agentes patogénicos perigosos escaparem dos laboratórios e causarem inúmeras mortes no futuro? Devemos confiar apenas nas boas intenções dos investigadores envolvidos?

Não, a primeira resposta deve ser falar sobre o risco – para se compreender melhor as condições em que um agente patogénico biológico pode escapar ao controlo humano e causar uma devastação generalizada.

O mesmo se passa com a possibilidade de uma devastação generalizada causada por um sistema pré-BGI que acabe por funcionar fora do controlo humano. A par de qualquer conversa inspiradora sobre as coisas maravilhosas que podem acontecer se a verdadeira BIG for alcançada, é necessário que haja uma discussão sóbria sobre as possíveis avarias dos sistemas pré-BIG. Caso contrário, antes de atingirmos o estado de superabundância sustentável para todos, que eu pessoalmente vejo como possível e desejável, poderemos vir a lamentar amargamente a nossa desatenção para com as questões de segurança global.

.png)

.png)

.png)

0 Comments

0 thoughts on “Para uma inteligência geral benéfica, as boas intenções não são suficientes! Três ondas de complicações: Pré-BGI, BGI e Pós-BGI”