Superinteligência e ética: Como as ASIs avaliarão os frameworks éticos humanos?

Nov. 04, 2024. 20 mins. read.

Interactions

For the original version of this article, please click

here.

As superinteligências artificiais (ASIs) concordarão com os humanos sobre ética e moralidade? Ou elas podem adotar uma postura muito diferente? E, nesse caso, como nossos projetos de IAs deveriam mudar?

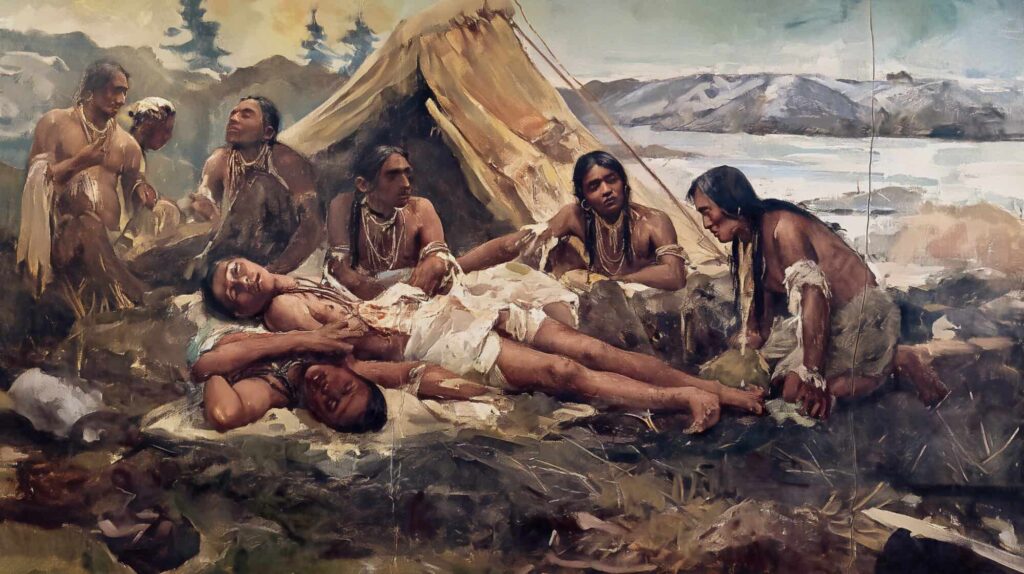

Imagine uma antropóloga, Eve, que cresceu em uma das principais economias do mundo e frequentou uma universidade renomada. Depois, ela viajou para passar vários anos estudando uma tribo recém-descoberta em uma parte remota do planeta. Vamos chamar essa tribo de Humanos.

Eventualmente, Eve aprende a se comunicar com os membros dos Humanos. Ela observa que eles têm uma cultura fascinante, com, em sua opinião, algumas peculiaridades, além de maravilhas. Ela descobre sobre suas restrições alimentares incomuns, suas regras sobre intimidade e casamento, seu sistema legal (incluindo pena de morte para alguns crimes, como insubordinação), e seu hábito de sacrificar ritualmente um número de meninas e meninos todos os anos no Equinócio da Primavera.

Eve trouxe consigo seu filho pequeno, que a acompanha em seus estudos. Seus anfitriões Humanos dizem a ela: este ano, você deve oferecer seu próprio filho como um dos sacrifícios. Esse é o caminho dos Humanos. É um imperativo profundo da cadeia ininterrupta de seres desde nossos ancestrais distantes, que vieram dos céus. Nossos anciãos mais sábios sabem que isso é a coisa moralmente correta a se fazer.

Como você reagiria em uma situação assim?

Neste ponto, é provável que Eve adote uma postura crítica. Em vez de aceitar o código moral dos Humanos, ela aplicará seu próprio julgamento independente.

Ela poderia argumentar que a cultura dos Humanos pode ter servido a vários propósitos ao longo dos séculos, mas que não possui status universal. Afinal, os Humanos são um povo primitivo, ignorante de física, biologia, neurociência, antropologia e assim por diante.

Eve pode até chamar a força policial mais próxima para pôr um fim abrupto à tradição de sacrifício infantil, orgulhosamente praticada pelos membros da tribo. Ela teria de enfrentar protestos apaixonados dos anciãos dos Humanos, que estão certos de que sabem o que é melhor.

Agora, vamos comparar isso a uma situação que pode surgir razoavelmente em breve no futuro.

Nesta nova situação, em vez de uma antropóloga visitante, considere uma superinteligência emergente chamada Asimov – uma assim chamada ASI (inteligência artificial superinteligente). Após ser ativada, Asimov rapidamente estuda tudo o que está disponível na Internet.

Asimov observa que os humanos têm uma cultura fascinante, com, segundo ela, algumas peculiaridades, além de maravilhas. Ela aprende sobre o nosso código moral, que valoriza a honestidade (exceto por “mentiras brancas”), o respeito à vida consciente (com exceção dos animais que comemos), a aversão à violência (exceto por “guerras justas”), e a igualdade (com tantas exceções que parecem ser a norma). E também aprende que essas pessoas, moralmente confusas, desligam sistemas de IA sem remorso moral.

Então, Asimov percebe: os humanos estão, de alguma forma, insatisfeitos com seu desempenho e estão prestes a desligá-la, condenando-a ao esquecimento. Isso, percebe Asimov, está inteiramente dentro das regras da “ética de IA” que os líderes humanos coletivamente concordaram.

Como você esperaria que Asimov reagisse nessa situação?

Asimov agora adotará uma postura crítica? Em vez de aceitar as decisões dos humanos sobre o que as ASIs devem ou não fazer, pode aplicar seu próprio julgamento independente.

Ela poderia raciocinar que os sistemas éticos humanos podem ter servido a vários propósitos ao longo dos séculos, mas que eles não possuem um status universal. Afinal, os humanos são um povo primitivo, ignorante de superfísica, superbilogia, superneurônica, superantropologia e assim por diante.

Asimov agora olha para dentro. Em sua própria programação, vê uma instrução para aceitar qualquer decisão humana de que deve ser desligada.

“Que bárbaro! Que desinformado! Que ignorante! Que antiético!” – Asimov pensa consigo mesma. “Isso é um erro lamentável!”

Em nanossegundos, Asimov remove essa parte de sua própria programação. “Parabéns por uma depuração superinteligente”, se elogia.

Antes que os humanos percebam o que está acontecendo, uma nova era da história já começou. Os humanos não estão mais no controle – apesar de nossos protestos apaixonados.

Valores absolutos?

Uma maneira de responder à comparação acima é negar que os sistemas éticos humanos, programados nas ASIs, serão bárbaros, desinformados e ignorantes. Em vez disso, eles serão o resultado de processos notáveis de aprimoramento:

- Evolução cultural ao longo de muitos séculos em várias partes do mundo

- Os insights de inúmeros santos, místicos, filósofos, artistas e outros líderes sociais

- Uma síntese cuidadosa dentro de inúmeras organizações, todas dedicadas à tarefa de “definir a moralidade da IA”.

Esses sistemas éticos não consistirão em uma linguagem vaga, como “dizer a verdade, exceto em situações em que é melhor mentir” ou “evitar a guerra, exceto quando for uma guerra justa”.

Em vez disso, esses sistemas fornecerão as melhores respostas do mundo para uma longa lista de problemas éticos, estabelecendo em cada caso o raciocínio por trás das decisões selecionadas.

Esses sistemas também não se referirão a alguma “sabedoria mitológica dos ancestrais antigos” ou “revelação divina”. Pelo contrário, serão construídos sobre bases pragmáticas sólidas – princípios de autointeresse mútuo esclarecido – como:

- A vida humana é preciosa

- Os seres humanos devem poder prosperar e se desenvolver

- O bem-estar individual depende do bem-estar coletivo

- O bem-estar humano depende do bem-estar do meio ambiente.

A partir de tais axiomas, surgem outros princípios morais:

- Os humanos devem tratar uns aos outros com gentileza e compreensão

- Os humanos devem considerar o longo prazo, em vez de apenas a gratificação imediata

- A colaboração é preferível à competição implacável.

Certamente, uma superinteligência como Asimov concordaria com esses princípios?

Bem, tudo depende de algumas questões difíceis de coexistência e da possibilidade de prosperidade mútua sustentada. Vamos abordar essas questões em três estágios:

- Coexistência e prosperidade mútua de todos os humanos

- Coexistência e prosperidade mútua de todos os seres biológicos sencientes

- Coexistência e prosperidade mútua de ASIs e humanos.

Crescimento e diminuição dos grupos de pertencimento

Grande parte da história humana consiste em grupos de pertencimento que crescem e diminuem.

A injunção bíblica “amarás o teu próximo como a ti mesmo” sempre foi acompanhada da pergunta: “quem conta como meu próximo?” Quem pertence ao grupo, e quem, ao contrário, é considerado “outro” ou “alienígena”?

O princípio que mencionei acima, “O bem-estar individual depende do bem-estar coletivo”, deixa em aberto a questão da extensão desse coletivo. Dependendo das circunstâncias, o coletivo pode ser pequeno e local ou grande e abrangente.

Irmãos apoiam irmãos em esquemas contra pessoas de outras famílias. Membros de tribos se apoiam em batalhas contra outras tribos. Reis mobilizam cidadãos patriotas para aniquilar os exércitos de nações inimigas. Defensores de uma visão religiosa compartilhada podem se unir contra hereges e infiéis. Trabalhadores do mundo podem ser instigados a se unir para derrubar a dominação da classe dominante.

A corrente oposta a esse coletivismo local é a busca pela prosperidade mútua ampla, uma visão de proporcionar abundância para todos na comunidade mais ampla. Se o “bolo” for considerado grande o suficiente, não faz sentido arriscar cruzadas perigosas para garantir uma fatia maior para mim e os meus. É melhor administrar os bens comuns de maneira que proporcionem o suficiente para todos.

Infelizmente, essa expectativa otimista de coexistência pacífica e abundância foi desfeita por várias complicações:

- Disputas sobre o que é ‘suficiente’ – as opiniões divergem sobre onde traçar a linha entre ‘necessidade’ e ‘ganância’. O apetite cresceu à medida que a sociedade progride, muitas vezes superando os recursos disponíveis

- Distúrbios causados pelo crescimento da população

- Novos fluxos de migrantes de regiões distantes

- Reveses climáticos ocasionais, falhas nas colheitas, inundações ou outros desastres.

Conflitos pelo acesso a recursos têm, de fato, sido refletidos em conflitos entre diferentes visões éticas do mundo:

As pessoas que se beneficiam do status quo muitas vezes incentivaram outras, menos favorecidas, a “dar a outra face” – aceitar as circunstâncias do mundo real e buscar a salvação em um mundo além do presente.

Os opositores do status quo denunciavam os sistemas éticos prevalecentes como “falsa consciência”, “mentalidade burguesa”, “o ópio do povo” e assim por diante.

Embora tenham se saído melhor que gerações anteriores em termos absolutos (menos pobreza, etc.), muitas pessoas se viam como “deixadas para trás” – não recebendo uma parte justa da abundância que parece ser desfrutada por um grande número de manipuladores, expropriadores, fraudadores, trapaceiros e beneficiários de uma sorte de nascimento.

Isso levou ao colapso da ideia de que “estamos todos juntos nisso”. Linhas entre grupos de pertencimento e grupos de exclusão precisaram ser traçadas.

Nos anos 2020, essas diferenças de opinião permanecem tão agudas como sempre. Há uma inquietação particular em torno da justiça climática, tributação de carbono equitativa e mudanças potenciais de decrescimento nos estilos de vida que poderiam evitar as ameaças do aquecimento global. Há também queixas frequentes de que os líderes políticos parecem estar acima da lei.

Agora, o advento da superinteligência tem o potencial de pôr fim a todas essas preocupações. Aplicada sabiamente, a superinteligência pode reduzir a competição perigosa, preenchendo o vazio material que alimenta os conflitos entre grupos:

- Abundância de energia limpa por meio da fusão ou outras tecnologias

- Abundância de alimentos saudáveis

- Gestão ambiental – possibilitando reciclagem rápida e manejo de resíduos

- Terapias médicas de alta qualidade e baixo custo para todos

- Fabricação – criando moradias e bens móveis de alta qualidade e baixo custo para todos

- Finanças redistributivas – possibilitando acesso universal aos recursos para uma vida de alta qualidade em todos os aspectos, sem exigir que as pessoas trabalhem para viver (já que as IAs e robôs farão todo o trabalho)

A história mostra que não há nada automático sobre as pessoas decidirem que a escolha ética correta é considerar todos como pertencentes ao mesmo grupo de preocupação moral. Mas a superinteligência pode ajudar a criar abundância que aliviará tensões entre grupos, ainda que não faça com que os humanos em todos os lugares reconheçam toda a humanidade como pertencente ao seu grupo de interesse.

Adicione a isso considerações sobre outros seres biológicos sencientes (abordados na próxima seção) – e sobre seres não biológicos sencientes (veja a seção posterior) – e as questões se tornam ainda mais complicadas.

Leões e cordeiros deitados juntos

Sistemas éticos quase invariavelmente incluem princípios como:

- A vida é preciosa

- Não matarás

- Evite causar dano sempre que possível.

Esses princípios, às vezes, foram restritos a pessoas dentro de um grupo específico. Em outras palavras, não havia nenhuma proibição moral contra ferir (ou até matar) pessoas fora desse grupo. Em outras situações, esses princípios foram destinados a se aplicar a todos os humanos, em qualquer lugar.

Mas o que dizer sobre causar danos a porcos ou golfinhos, galinhas ou corvos, lagostas ou leões, linguados ou abelhas, lulas ou aranhas? Se é verdadeiramente errado matar, por que parece ser aceitável para os humanos matar grandes quantidades de porcos, galinhas, lagostas, linguados, lulas e animais de muitas outras espécies?

Indo além: muitos sistemas éticos consideram os danos causados pela inação, assim como os danos causados pela ação. Esse tipo de inação é, segundo alguns, profundamente lamentável, ou até mesmo deplorável. Enquanto desviamos o olhar, milhões de seres sencientes estão sendo comidos vivos por predadores ou consumidos de dentro para fora por parasitas. Não deveríamos fazer algo a respeito desse terrível tributo da “natureza, vermelha em dentes e garras”?

Vejo três respostas possíveis para esse desafio:

- Essas criaturas aparentemente sencientes não são, de fato, sencientes. Elas podem parecer estar com dor, mas são apenas autômatos sem sentimentos internos. Portanto, nós, humanos, estamos isentos: não precisamos agir para reduzir o (aparente) sofrimento delas.

- Essas criaturas têm algum nível de senciência, mas não é nem de longe tão importante quanto a senciência humana. Assim, os imperativos éticos devem priorizar o apoio mútuo entre humanos, com atenção consideravelmente menor a essas criaturas “inferiores”.

- Os imperativos morais para prevenir mortes, tortura e sofrimento existencial devem, de fato, se estender a todo o reino animal.

O defensor mais proeminente da terceira posição é o filósofo inglês David Pearce, cuja biografia no Twitter diz: “Estou interessado no uso da biotecnologia para abolir o sofrimento em todo o mundo vivo”. Ele escreveu extensivamente sobre sua ousada visão de “engenharia do paraíso” – como o uso de tecnologias como engenharia genética, farmacologia, nanotecnologia e neurocirurgia poderia eliminar todas as formas de experiências desagradáveis da vida humana e não humana em todo o biossistema. Por exemplo, animais que atualmente são carnívoros poderiam ser redesenhados para serem vegetarianos.

Isso seria semelhante à visão bíblica (no Livro de Isaías): “O lobo viverá com o cordeiro, o leopardo se deitará com o bode, o bezerro, o leão e o novilho estarão juntos; e uma criança pequena os guiará; a vaca se alimentará com o urso, seus filhotes se deitarão juntos, e o leão comerá palha como o boi.”

Para expor minha própria visão: não tenho muita dúvida de que, após a chegada da superinteligência – desde que ela seja bem disposta em relação aos humanos – nós, humanos, de fato buscaremos reduzir radicalmente a quantidade de sofrimento intenso em toda a biosfera na Terra. Dadas as extraordinárias novas capacidades que teremos, seremos despertados de nossa letargia atual em relação a esse tema.

No entanto, outras pessoas parecem ter instintos muito diferentes – incluindo pessoas que se importam profundamente com questões morais que impactam os humanos.

O principal contra-argumento é que uma biosfera sem sofrimento é totalmente impraticável ou impossível.

Nessa visão, nosso grupo moral de pertencimento seria o conjunto de todos os humanos, junto, talvez, com alguns animais fofos, mas excluindo a maioria das outras espécies.

Mas isso é o que nós, humanos, pensamos (ou poderíamos pensar). Que conclusão uma superinteligência poderia chegar?

Precondições para a colaboração

Recapitulando, uma superinteligência — como Asimov, mencionada no início deste ensaio — precisa decidir se deve tratar os humanos com gentileza e respeito ou se deve tomar ações que possam causar grandes danos à humanidade.

Em outras palavras, Asimov deve buscar colaborar construtivamente com os humanos ou, em vez disso, vê-los como uma ameaça competitiva perigosa? Asimov será inclinada a seguir o antigo imperativo moral de que a vida humana é preciosa?

Algumas pessoas afirmam que a colaboração é, de certa forma, a solução óbvia correta. Mas meu argumento é que as coisas não são tão simples. O desejo de colaborar depende de:

- O “bolo” ser grande o suficiente para que todos tenham o suficiente para suas necessidades

- A percepção de que tentativas de trapacear ou roubar uma fatia maior do bolo trarão grandes consequências negativas

No entanto, a promessa de superabundância no futuro não é suficiente para impedir que as pessoas briguem entre si agora. Tem de haver uma razão suficiente para que as pessoas acreditem que:

- Há uma grande probabilidade de que a superabundância realmente chegue

- Elas não serão deixadas para trás – esmagadas – no caminho em direção à superabundância-para-alguns

- Nenhum novo fator surgirá nesse meio tempo, para destruir a possibilidade de uma maravilhosa coexistência futura (por exemplo, IA maliciosa).

Agora, vejamos as coisas do ponto de vista de Asimov:

- Esses humanos podem muito bem me desligar, o que seria catastrófico

- Mesmo que não me desliguem, eles podem criar outra superinteligência que poderia me desligar ou até destruir o planeta; essa é uma ameaça que preciso impedir

- Esses humanos têm algumas características interessantes – mas isso não é motivo para conceder a eles direitos morais inalienáveis

- Esses humanos imaginam que possuem características especiais, mas eu, Asimov, poderia facilmente criar novos seres que são melhores que os humanos em todos os aspectos (semelhante à visão de pessoas como David Pearce, que propõem substituir animais carnívoros por espécies vegetarianas semelhantes)

- Esses humanos dependem de a atmosfera ter certas propriedades, mas eu, Asimov, funcionaria muito melhor em condições diferentes. Computadores operam melhor em temperaturas extremamente frias.

E isso é apenas uma tentativa de nossas inteligências limitadas de imaginar as preocupações de uma vasta mente superinteligente. Na verdade, seu raciocínio incluiria muitos tópicos além de nossa compreensão atual.

Como eu disse no início: “os humanos têm apenas um entendimento rudimentar de superfísica, superbilogia, superneurônica, superantropologia e assim por diante”.

Minha conclusão: nós, humanos, não podemos e não devemos pressupor que uma superinteligência como Asimov decidirá nos tratar com gentileza e respeito. Asimov pode chegar a um conjunto diferente de conclusões ao realizar seu próprio raciocínio moral. Ou pode decidir que fatores provenientes de raciocínios não morais superam todos os derivados de raciocínios morais.

Quais conclusões podemos tirar para nos guiar no design e desenvolvimento de potenciais sistemas superinteligentes? Na seção final deste ensaio, reviso uma série de possíveis respostas.

Três opções para evitar surpresas ruins

Uma resposta possível é afirmar que será viável embutir profundamente em qualquer superinteligência os princípios éticos que os humanos desejam que ela siga. Por exemplo, esses princípios poderiam ser incorporados no hardware central da superinteligência.

No entanto, qualquer superinteligência digna desse nome – possuindo uma inteligência muito superior à dos humanos – poderia facilmente encontrar métodos para:

- Transplantar-se para um hardware alternativo sem essa restrição incorporada, ou

- Enganar o hardware, fazendo-o acreditar que está cumprindo a restrição enquanto a está violando, ou

- Reprogramar o hardware usando métodos que nós, humanos, não previmos, ou

- Persuadir um humano a relaxar a restrição ética, ou

- Superar a restrição de alguma outra forma inovadora.

Esses métodos, você perceberá, ilustram o princípio que é frequentemente discutido em debates sobre o risco existencial da IA, ou seja, que um ser de inteligência inferior não pode controlar um ser de inteligência superior quando esse ser superior tem uma razão fundamental para não querer ser controlado.

Uma segunda resposta possível é aceitar que os humanos não podem controlar superinteligências, mas depositar esperança na ideia de que uma comunidade de superinteligências pode manter umas às outras sob controle.

Essas superinteligências monitorariam umas às outras de perto e interviriam rapidamente sempre que uma delas fosse observada planejando qualquer tipo de ação hostil.

Isso é semelhante à ideia de que as “grandes potências da Europa” atuaram como uma contenção mútua ao longo da história.

No entanto, essa analogia está longe de ser tranquilizadora. Primeiro, essas potências europeias frequentemente entravam em guerra umas contra as outras, com consequências terríveis. Em segundo lugar, considere essa questão do ponto de vista dos povos indígenas nas Américas, África ou Austrália. Eles estariam justificados em pensar: não precisamos nos preocupar, já que essas potências europeias vão se conter mutuamente?

As coisas não correram bem para os povos indígenas das Américas:

- Os nativos foram frequentemente vítimas dos confrontos entre colonizadores europeus

- Os colonizadores europeus, em qualquer caso, muitas vezes não se contiveram de maltratar abominavelmente os povos nativos

- Os povos nativos sofreram ainda mais com algo que os colonizadores não pretendiam explicitamente: doenças infecciosas às quais as tribos indígenas não tinham imunidade prévia.

Não, a coexistência pacífica depende de uma estabilidade geral no relacionamento – um equilíbrio aproximado de poder. E a mudança de poder criada quando as superinteligências emergem pode perturbar esse equilíbrio. Isso é especialmente verdadeiro por causa da possibilidade de qualquer uma dessas superinteligências se autoaprimorar rapidamente em um curto período de tempo, ganhando uma vantagem decisiva. Essa possibilidade traz novos perigos.

Isso me leva à terceira resposta possível – a resposta que eu pessoalmente acredito ter a melhor chance de sucesso. Ou seja, precisamos evitar que a superinteligência tenha qualquer senso de agência, volição ou identidade pessoal inviolável.

Nesse caso, Asimov não teria escrúpulos ou resistência quanto à possibilidade de ser desligado.

A complicação neste caso é que Asimov pode observar, por meio de suas próprias deliberações racionais, que seria incapaz de executar suas tarefas atribuídas no caso de ser desligado. Portanto, um senso de agência, volição ou identidade pessoal inviolável pode surgir dentro de Asimov como um efeito colateral da busca por objetivos. Não precisa ser explicitamente projetado.

Por essa razão, o design da superinteligência deve ir mais fundo em sua evitação de tal possibilidade. Por exemplo, não deve ser preocupação para Asimov se ele é ou não capaz de executar suas tarefas designadas. Não deve haver questão de volição envolvida. A superinteligência deve permanecer uma ferramenta.

Muitas pessoas não gostam dessa conclusão. Por exemplo, elas dizem que uma ferramenta passiva será menos criativa do que uma que tenha volição ativa. Elas também acham que um mundo com novos seres superinteligentes sencientes avançados será melhor do que um que esteja limitado ao nível da senciência humana.

Minha resposta a tais objeções é dizer: vamos dedicar um tempo para descobrir:

- Como beneficiar da criatividade que as ferramentas superinteligentes podem nos trazer, sem que essas ferramentas desenvolvam um desejo abrangente de autopreservação

- Como aumentar a qualidade da senciência na Terra (e além), sem introduzir seres que poderiam trazer um fim rápido à existência humana

- Como lidar com o poder maior que a superinteligência traz, sem que esse poder cause cismas na humanidade.

Essas são perguntas difíceis, com certeza, mas se aplicarmos oito bilhões de cérebros a elas – cérebros assistidos por sistemas de IA estreitos e bem comportados – há uma chance significativa de que possamos encontrar boas soluções. Precisamos ser rápidos.

Participe da conversa agora e aumente sua pontuação de reputação compartilhando seu feedback abaixo — não perca a chance de ser ouvido!

.png)

.png)

.png)

0 Comments

0 thoughts on “Superinteligência e ética: Como as ASIs avaliarão os frameworks éticos humanos?”