TESCREALismo

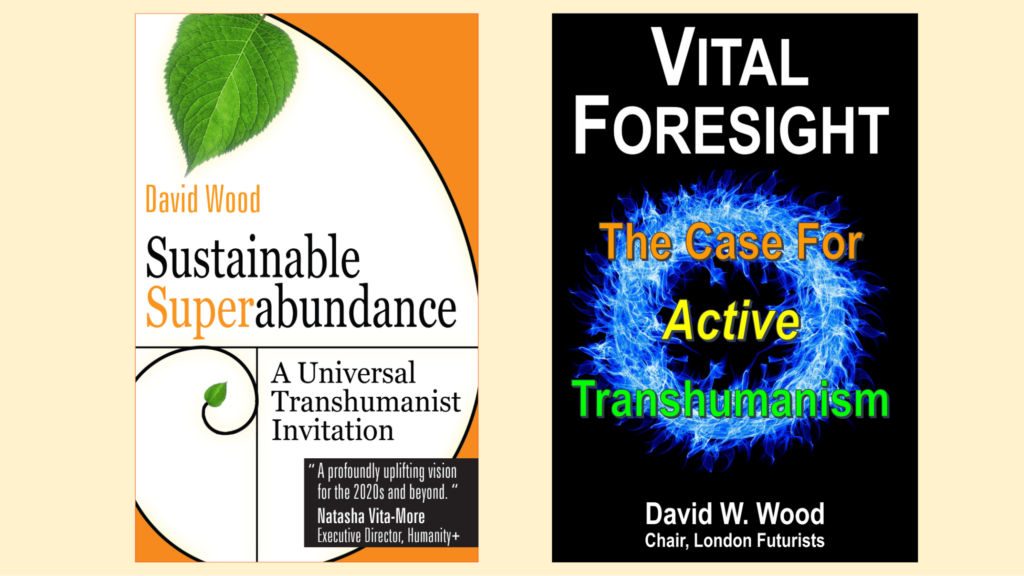

T=Transhumanismo

E=Extropianismo

S=Singularitarianismo

C=Cosmismo

R=Racionalismo

EA=Altruísmo Eficaz

L=Longtermismo

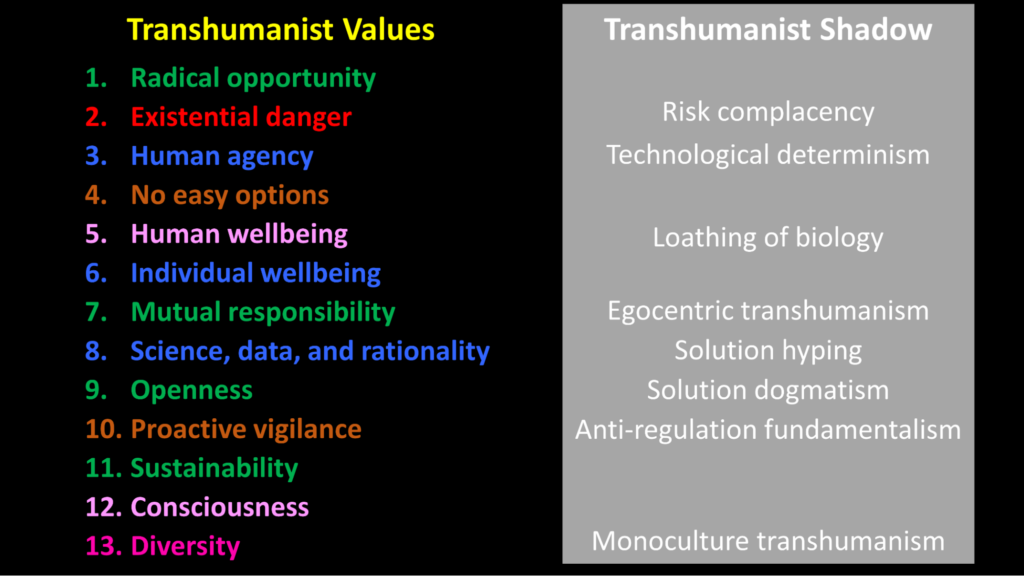

Émile Torres, filósofo e historiador que recentemente se debruçou sobre ameaças existenciais, desenvolveu o que chama de “bundle” (poderíamos chamá-lo de memeplex) que pretende ligar a série de -ismos acima em uma espécie de força singular que foi abraçada por muitos dos super-ricos e influentes no mundo da tecnologia. É a influência desses -ismos sobre os super-ricos e influentes que, na visão de Torres, os torna muito perigosos.

Em um artigo para a Truthdig, Torres escreve: “No coração do TESCREALismo está uma visão ‘tecno-utópica’ do futuro”. Ele antecipa um tempo em que as tecnologias avançadas permitem que a humanidade açcance coisas como: produzir abundância radical, reinventar-se, tornar-se imortal, colonizar o universo e criar uma civilização “pós-humana” entre as estrelas cheias de trilhões e trilhões de pessoas. A maneira mais simples de realizar essa utopia é construindo AGI superinteligente.”

No mesmo artigo, Torres entra nas projeções mais selvagens que suspeito que até mesmo muitos leitores do Mindplex orientados para o transhumanismo tecno-entusiasmado achariam fantásticos (enraizados em mentes brilhantes levando suas fantasias para a realidade), o teorema de Torres se apoia fortemente nas opiniões do professor de Oxford Nick Bostrom, escrevendo que ele “argumenta que se houver apenas 1% de chance de 10^52 vidas digitais existentes no futuro, Então, “o valor esperado de reduzir o risco existencial em apenas um bilionésimo de um bilionésimo de um ponto percentual vale cem bilhões de vezes mais do que um bilhão de vidas humanas”. Em outras palavras, se você mitiga o risco existencial com essa quantidade minúscula, então você fez o equivalente moral de salvar bilhões e bilhões de vidas humanas existentes.”

Como explicou em sua conversa com Douglas Rushkoff, Torres identifica o TESCREALismo como um “pacote” filosófico que, de certa forma, banaliza as vidas e sofrimentos dos humanos atualmente existentes, encontrando uma importância maior nos possivelmente trilhões de pós-humanos que poderiam existir no espaço físico e/ou virtual no futuro – “pessoas” tendo experiências que podem ser valorizadas além do que imaginamos. Alguns dos citados tendem a usar a estatística para valorizar a experiência, que é tão alienada da experiência quanto você pode obter.

Posso supor que todos vocês saibam sobre o transumanismo e a singularidade. Se você está aqui, provavelmente conhece o projeto de Ben Goertzel para construir o AGI. Mas a maioria de vocês está familiarizada com as excentricidades e extremidades que se ligaram ao Racionalismo (como definido por LessWrong), Altruísmo Eficaz e Longo Prazo?

Na entrevista abaixo, peço principalmente a Torres que esclareça o quão real tudo isso é. Muita gente compra todo o bundle filosófico? Minha própria atitude, mesmo como um associado de longa data do transhumanismo, sempre foi uma espécie de “você é de verdade?” quando se trata de pessoas levando sua merda muito a sério, particularmente quando elas se iludem pensando que são racionais.

Em uma enquete de acompanhamento, pedirei aos leitores da Mindplex e veteranos da cultura transumanista que avaliem o bundle TESCREAL.

RU Sirius: Em seu livro Human Extinction: A History of the Science and Ethics of Annihilation, você passou de escrever sobre ameaças existenciais como um fenômeno histórico para vários tropos (-ismos) transumanistas. Enquanto eu estava lendo, foi como se de repente tivéssemos passado da ciência e da geologia para a ficção científica. Então eu estava me perguntando se havia ficção científica em tempos mais antigos. (Suponho que houvesse a Bíblia e outros mitos.) Como você entrou nisso?

Émile Torres: Em meados dos anos 2000, encontrei o transumanismo pela primeira vez. E eu inicialmente fui muito crítico em relação a isso. O segundo artigo que publiquei foi uma crítica ao transumanismo. Mas então, certas considerações me levaram a acreditar que o transumanismo é uma posição defensável, e eu me tornei uma espécie de transumanista.

E uma das principais considerações foi que o desenvolvimento dessas tecnologias é inevitável. Então, se você vai ser contra o transumanismo, então talvez você precise ser contra o desenvolvimento de certas tecnologias de engenharia de pessoas. Mas como são inevitáveis, não adianta se opor apenas para segurar a maré. Portanto, a melhor coisa a fazer é juntar-se aos transumanistas e fazer o que puder para garantir que esse projeto seja realizado da maneira mais ideal.

A noção de risco existencial esteve intimamente ligada ao transumanismo desde o início: o risco existencial foi inicialmente definido como “qualquer coisa que pudesse nos impedir de criar uma civilização pós-humana”.

RUS: Tenho certeza de que deve ter havido menção ao risco existencial antes disso em vários círculos intelectuais… como relacionado à guerra nuclear e assim por diante?

ÉT: Definitivamente se falava em extinção e catástrofe global. Mas o que há de novo nessa ideia de risco existencial – ali mesmo na definição – é a ideia de desenvolvimento futuro desejável.

Havia pessoas, particularmente na segunda metade do século 20, argumentando que uma razão pela qual a extinção humana seria ruim é que ela impediria a realização de todo o progresso futuro, felicidade futura e assim por diante. Mas esse argumento de potencial perdido nunca foi formalizado. O foco era mesmo a extinção. Todo mundo na terra vai morrer. Você e eu vamos morrer. Nossas famílias morrerão. Esse foi o primeiro plano. O potencial perdido não foi proeminente.

A noção de risco existencial, eu acho, inverteu isso e colocou em primeiro plano o potencial perdido: o argumento passou a ser que o pior aspecto da extinção humana é o potencial perdido. Não são os 8 bilhões de pessoas que vão morrer. Isso é muito ruim, mas a maldade de todo o potencial perdido é ordem de grandeza maior.

RUS: Posso estar um pouco fora de contato com a cultura transumanista… Para mim, isso é uma iteração bizarra do transumanismo. Não é algo que eu esbarrei muito quando estava interagindo com esse mundo em 2007-2010 como editor da h+ magazine. Naquela época, você ouvia falar principalmente sobre extensão de vida e outras melhorias. Ou a imortalidade, se você quisesse chegar muito longe. A noção de crianças super dotadas já existia, mas como algo muito especulativo. Mas a ideia de sacrificar quase todo mundo por pessoas um em futuro imaginário, como você discutiu em seus escritos sobre o TESCREAL, não parecia estar muito em circulação naquela época.

ÉT: Isso me parece certo. Acho que essa noção de potencial é realmente central para o longo prazo. A definição inicial vem de 2002, com Bostrom discutindo a dinâmica de transição de nossa civilização humana para uma civilização pós-humana, colocando em primeiro plano o potencial de nos tornarmos pós-humanos. Isso também estava ligado a essa noção de que a criação da pós-humanidade não é apenas valiosa porque é uma boa maneira de a história cósmica se desenrolar. Mas também, você e eu podemos nos beneficiar, certo?

Então, por que criar uma civilização pós-humana é importante (de acordo com Bostrom e pessoas como ele)? Bem, porque se isso acontecer dentro da minha vida, talvez eu consiga viver para sempre. Ou mesmo se isso acontecer dentro de talvez mil anos, eu ainda consigo viver para sempre porque vou me inscrever na ALCOR e ressuscitar. Então, eu realmente vejo esse momento em que há uma espécie de pivô para pensar no futuro distante. Acho que, inicialmente, para os transumanistas, isso estava ligado ao seu próprio destino como indivíduos.

RUS: Eu estava pensando que talvez – por exemplo – Eliezer Yudkowsky esteja sendo altruísta quando fala sobre arriscar uma guerra nuclear e sacrificar a maior parte da vida no planeta para garantir que a IA não aconteça antes que ele pense que estamos prontos. Porque me parece que ele poderia ter pelo menos uma chance de 50:50 de ser vítima da guerra nuclear que ele está disposto a arriscar para impedir o desenvolvimento da IA cedo demais. Então, estou pensando que ele está sendo altruísta, mas ele ama tanto a ideia dos futuros humanos felizes que está disposto a se sacrificar.

ÉT: Meu entendimento da história é que foi realmente nos anos 2000 que as pessoas dessa comunidade se tornaram cada vez mais conscientes do quão grande o futuro poderia ser. Com essa consciência, veio uma mudança correspondente na ênfase moral.

Yudkowsy quer viver para sempre. No podcast de Lex Fridman, ele disse que cresceu acreditando que viveria para sempre. Então, parte do trauma para ele, como ele mencionou naquele podcast, é estar nessa situação em que a AGI está tão próxima, e ele está tendo que enfrentar sua própria mortalidade, talvez pela primeira vez. Parece que seu pensamento exemplifica esse pivô ao longo dos anos 2000.

RU: Para mim parece que é tudo fantasia. Algumas dessas coisas que você mencionou fazer parte desse bundle – como os trilhões teóricos de pessoas, incluindo pessoas digitais, tendo uma experiência quantitativamente ótima – soa como brainstorms de nerd chapados que simplesmente nunca termina. Eles continuam elaborando a partir da premissa original, ficando cada vez mais isolados das experiências do mundo real. As ideias costumavam amadurecer – agora parecem ficar mais malucas. Não posso provar, mas pode ser resultado da economia da atenção. Para citar erroneamente Neils Bohr: “Sua ideia é louca, mas não é louca o suficiente para conseguir seguidores nas redes sociais”.

ÉT: Com relação à economia da atenção, minha sensação é que os longtermistas reconhecem que essa visão de futuro é meio maluca. Quero dizer, alguns deles usaram o termo “Crazu Town”. Consequentemente, acho que eles fazem o possível para evitar mencionar publicamente quais são seus objetivos reais. Ideias malucas chamam a atenção do público, mas, neste caso, acho que eles sentem que algumas dessas ideias não são boas relações públicas.

E quanto à IA útil?

RUS: Em relação à sua afirmação de que a atividade da IA só pode ser explicada por essa configuração ideológica. Não sei se você está falando de IA prática para, digamos, rastrear e responder às condições climáticas, desenvolver vacinas e outras respostas a pandemias, desenvolver medicamentos, etc. Ou se você está se referindo apenas à IA que está realizando o que consideramos coisas intelectuais ou criativas.

ÉT: Não acho que a IA em geral seja motivada por essa ideologia. A corrida para a AGI é. E acho que há dois fatores. Uma que é óbvia é o motivo do lucro. A Microsoft e o Google esperam ganhar bilhões de dólares com esses grandes modelos de linguagem. Mas acho que o outro componente crucial do quadro explicativo é o TESCREALismo.

É como… por que a DeepMind se formou em primeiro lugar? Por que Demis Hassabis – que esteve em muitas dessas conferências transumanistas – o encontrou? E Shane Legg, que recebeu US$ 100 mil do Canadian Singularity Institute for Artificial Intelligence após concluir sua tese de doutorado, e deu palestras nas conferências Singularity Summit.

RUS: Se eu fosse a todas as salas de reuniões no Vale do Silício e conversasse com os proprietários e os programadores, você acha que a maioria deles abraçaria toda essa ideia do TESCREAL? Meu palpite é que eles tenderiam a ser transumanistas, e muitos podem ser singularitários, mas provavelmente não estão no aspecto de “trilhões de pessoas futuras” desse projeto. Quer dizer, quão onipresentes são essas ideias realmente?

ÉT: Em termos da onipresença das crenças do TESCREAL, acho que você está certo. Muitos deles nem usariam a palavra transumanismo. Você poderia perguntar: “Você apoiaria a reengenharia do organismo humano?” Ou pergunte: “Você está financiando projetos para tentar reprojetar o organismo humano para que possamos fundir a IA em nossos cérebros?” Acho que muitos diriam que sim. E seriam para aspectos da visão de mundo de longo prazo, como o imperativo de colonizar o espaço e saquear o cosmos. Minha forte suspeita é que é na água que essas pessoas nadam.

Um artigo que eu quero escrever seria sobre os diferentes termos e ideias que vários autores usam para descrever a cultura do Vale do Silício – usando termos diferentes, mas em última análise descrevendo o mesmo fenômeno. Então, o que eu quero dizer com TESCREALismo é a mesma coisa que o cara de extrema direita Richard Hanania chama de “direita tecnológica”.

Houve um artigo do Huffington Post sobre como ele tem visões supremacistas brancas. E ele disse: “Eu odeio a palavra TESCREALismo”. Por isso, chamou-lhe “direito tecnológico”. Douglas Rushkoff chama isso de “mentalidade” – ele diz que está em todos os lugares do Vale do Silício entre bilionários de tecnologia e assim por diante; Ao conversar com eles sobre suas opiniões, ele descobriu que todos pensavam: “O futuro é digital. Vamos carregar nossas mentes. Vamos nos espalhar pelo espaço” e assim por diante. O que Rushkoff quer dizer com “mentalidade” é basicamente o que quero dizer com TESCREALISMO. Essas pessoas que incorporam “a mentalidade” diria: “Sim, sou um longtermista e acredito que a coisa moralmente mais importante a fazer é conquistar espaço e criar todas essas pessoas digitais no futuro?” Eu não sei. Mas sua visão de mundo se parece muito com o longo prazo.

RUS: Você acha que a falta de preocupação com as pessoas vivas atualmente é uma espécie de manifestação política da visão de longo prazo que está levando algumas pessoas do Vale do Silício ao extremismo de direita?

ÉT: Acho que isso está amplamente correto. Acho que algumas pessoas, como Wil Macaskill, [figura do “altruísmo efetivo“] realmente aceitam essa posição filosófica muito abstrata de que o que importa é que haja um grande número de pessoas no futuro. E muitos bilionários da tecnologia veem essa abordagem como ligada ao seu destino como indivíduos. Então o pensamento é como… “Quero construir um bunker para sobreviver ao apocalipse para poder chegar ao espaço, ter minha mente digitalizada” e assim por diante. E isso, definitivamente, pode levar a esse descaso com a maioria dos seres humanos. Um exemplo selvagem disso é a notícia que surgiu de que o irmão de Sam Bankman-Fried e outra pessoa na FTX discutiram a possibilidade de comprar a nação insular de Nauru explicitamente para que os membros do movimento de “altruísmo efetivo” pudessem sobreviver a um evento apocalíptico que mata até – como escreveram no documento – 99,9% dos seres humanos.

A singularidade provavelmente não está perto

RUS: Ben Goertzel disse que eu deveria perguntar se você acha que a Singularidade vai acontecer. E se vai acontecer, vai acontecer em 2035 ou 2050?

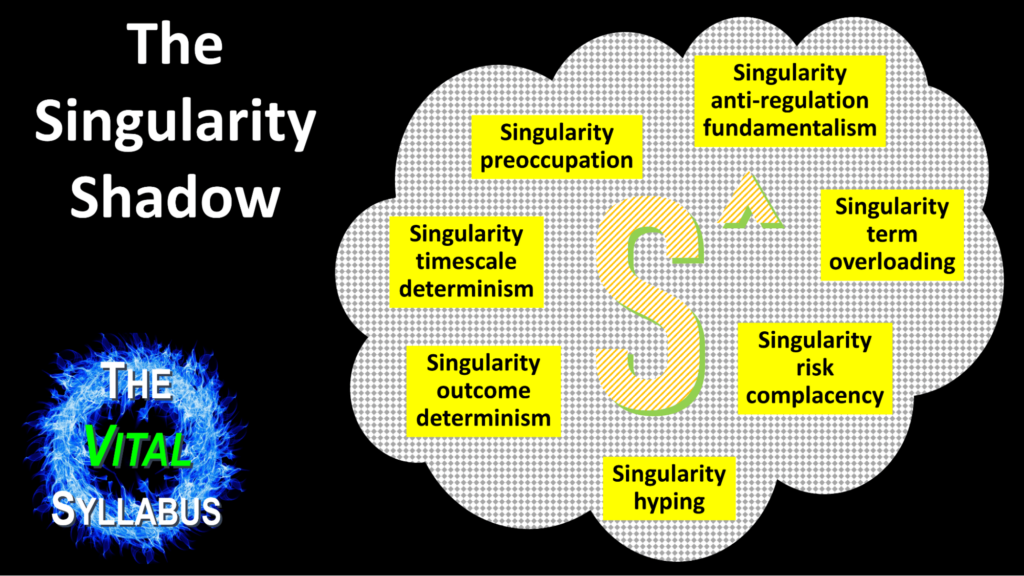

ÉT: Acho que depende do que se entende por Singularidade. Há a interpretação da explosão de inteligência… há a ideia Kurzweilian que só tem a ver com a taxa de mudança.

RUS: Eu penso na Singularidade como o ponto em que as IAs ficam mais inteligentes do que nós, e além disso, você não pode prever nada. Você não pode prever quem seremos, ou se estaremos por aqui, ou como será o mundo. O escritor de ficção científica Vernor Vinge foi a primeira pessoa a sugerir essa ideia de uma Singularidade. Faríamos inteligências que se tornariam tão incompreensíveis para nós quanto somos para os vermes.

ÉT: Sou simpático a essa visão da Singularidade. Simplesmente não há muito que possamos dizer além disso. Sou muito cético em relação à ideia de explosão de inteligência. E a ideia de taxa de mudança de Kurzweil parece estar em tensão direta e significativa com o fato de que uma catástrofe climática é quase inevitável, a menos que haja alguma nova tecnologia que, em escala, remova o dióxido de carbono da atmosfera.

RUS: Kurzweil mostra que a linha inclinada do desenvolvimento tecnológico humano sobreviveu a duas Guerras Mundiais (na verdade, guerras mundiais impulsionaram o desenvolvimento tecnológico) e Mao e Pol Pot e todos os tipos de eventos terríveis.

ÉT: Acho que as mudanças climáticas são diferentes disso.

RUS: Sim, eu também acho.

ÉT: Estamos falando de civilização global. Vai sobreviver? Eu não sei. Quero dizer, há climatologistas legítimos por aí que não acham que isso acontecerá, a menos que haja uma ação imediata para evitar mudanças climáticas catastróficas.

Lembro-me de discutir, há muitos anos, com colegas do campo do risco existencial, onde eu afirmava que as alterações climáticas são um problema muito maior do que eles suspeitavam. Eles pensaram: “Vamos inventar o AGI. E assim que tivermos o AGI, ele vai…”

RUS: Vai descobrir o que fazer, sim.

ÉT: Descubra o que fazer. Mas como vamos criar AGI em um mundo que está apenas desmoronando e caindo aos pedaços? Como vamos organizar conferências sobre IA quando o clima é tão hostil que você não pode chegar lá?

RUS: Acho que a questão se torna quão radical é a intervenção de catástrofes climáticas no futuro imediato. As pessoas estão pensando que podem ser capazes de realizar AGI nos próximos 10-20 anos ou mais. E já estamos lidando com todo tipo de mau tempo, mortes e destruição. Mas, aos olhos visíveis, a civilização ocidental parece rolar. As pessoas entram em seus carros e vão à loja. Os alimentos ainda estão sendo distribuídos.

Então, parece que estamos continuando, e talvez façamos isso por 10 ou 20 anos. Se as pessoas que fazem a AGI e robótica relacionada e assim por diante são capazes de conseguir chegar ao laboratório e fazer seu trabalho, entrar em seus carros e obter comida suficiente etc., então talvez eles possam realizar o que esperam. Acho que essa é a ideia.

ÉT: Não é a minha área de atuação. Mas minha sensação é que, em termos dos LLMs que temos, não há um caminho óbvio desses sistemas como o ChatGPT para AGI genuína ou superinteligência.

RUS: Muitas pessoas estão dizendo que o ChatGPT e afins não são muito para se gabar. Michio Kaku, que geralmente tende a ser um promotor de tecnologia hiper-otimista, chamou-lhe um gravador glorificado.

ÉT: Acho que foi Gary Marcus que estava rindo da ascensão e queda no prestígio, se quiserem, do ChatGPT. Virou piada durante um debate republicano.

RUS: Acontece muito rápido nos dias de hoje.

ÉT: Sim. Então, eu não acho que a Singularidade vai acontecer, provavelmente. E eu apostaria nisso não acontecendo tão cedo, não acontecendo em 2045 como Kurzweil prevê.

E os transumanistas humanos, singularitários e entusiastas da IA?

RUS: Deixe-me perguntar-lhe sobre as diferentes ideologias e ideais dentro do transhumanismo e seus derivados. Você mencionou Ben Goertzel – o capitão do navio aqui na Mindplex – em vários lugares como tendo um papel central no “bundle” por causa de sua busca de longa data pela AGI. E eu sei que Ben é um humanista, e mais ou menos um liberal ou até melhor. Eu sei que ele não quer explorar, escravizar ou matar as pessoas atuais na terra, mas quer tentar levantar todo mundo. Então, eu sei, por experiência, que há muita variação filosófica dentro do transhumanismo.

Lembro-me de quando me pediram para criar a revista para a humanity+, eu tinha minhas próprias suposições baseadas em experiências anteriores com os Extrópios. Então eu confessei para esses caras em uma reunião, eu disse: “Eu tenho que dizer a vocês logo de cara que eu não sou um libertário. Sou um esquerdista com uma veia libertária.” E um dos caras disse “sim, eu também”. E o outro cara disse: “Eu nem tenho certeza sobre a veia libertária”.

Geralmente, por volta dessa época – por volta de 2007 – aprendi que muitas das pessoas envolvidas com essa organização transumanista oficial se consideravam liberais, uma espécie de liberais convencionais convencionais. E há muita variação dentro desse mundo.

ÉT: Reconheço e afirmo isso. A noção de TESCREALismo deve captar a visão tecnoutópica que surgiu de alguns desses movimentos, e apontar para os piores aspectos disso. Acho que são os que se tornaram mais influentes agora. Assim, como o socialista democrático James Hughes, ele foi um tanto influente. Mas, comparado a alguém como Bostrom, sua influência é menor. E reconheço absolutamente que há transumanistas que gostam de antilibertários. Alguns deles são mórmons.

RUS: Sim… os transumanistas mórmons! Eles são adoráveis. Acho que quando você tinha pessoas como Peter Thiel e Elon Musk se apegando a essas ideias, elas provavelmente se tornaram os principais atratores do transhumanismo ou das ideias de aprimoramento humano associadas a ele. Mais pessoas que seriam atraídas por suas ideologias foram atraídas, particularmente na cultura do Vale do Silício. Esses monstros assustadores e super rasteiros da classe dominante se tornaram uma espécie de principal voz pública amplamente disponível para esse tipo de visão. Depois tivemos o movimento neorreacionário e o iluminismo sombrio. A maioria das pessoas que falavam sobre isso tendia a abraçar tropos transumanistas. Isso se tornou a alt-right; alimentou a propagação do extremismo de direita.

Você pode ver como a ideia do futuro glorioso – levante-se reto e alto e atire-se para o futuro glorioso – poderia atrair um certo tipo de sensibilidade fascista.

ÉT: Essa é a minha impressão também. Obviamente, há uma história fascinante envolvendo futurismo e fascismo. Talvez tenda a atrair um certo tipo de pessoa ou se preste a ser interpretado ou explorado por fascistas. O TESCREALismo capta esse aspecto.

Menos errado é um culto?

RUS: Lembro-me de estar em uma Conferência da Singularity e ser abordado por alguém envolvido no menos errado E parecia algo como ser abordado por uma seita. Eu me pergunto se você se depara com algum comportamento de culto real em seus estudos, como pessoas se reunindo em comunidades e pegando armas para se defender, ou adorar o líder e esse tipo de coisa.

ÉT: Há definitivamente esse aspecto de líder carismático no racionalismo. Há esses posts menos errado que estão apenas esbanjando elogios a Yudkowsky. Lembro-me de ver uma lista de uma ou duas frases sobre Yudkowsky. Um deles era algo sobre como “dentro da glândula pineal de Eliezer Yudkowsky não há uma alma imortal, mas outro cérebro”. “Na história dos pensadores ocidentais, havia Platão, Immanuel Kant, Eliezer Yudkowsky.” (Risos) Alguém que não vou citar o nome me disse que a cena racional da Bay Area é um culto ao apocalipse adulto.

Acho que o EA (Altruísmo Efetivo) é uma espécie de culto. Houve um artigo publicado por Carla Cremer recentemente. Ela falou sobre um sistema secreto de classificação competitiva em que os participantes recebem pontos subtraídos se tiverem QI inferior a 120.

RUS: Ah! Eu estava pensando em perguntar às pessoas envolvidas no transumanismo se elas acreditam mesmo no QI como uma medida legítima da inteligência.

ÉT: Eu ficaria muito curioso para saber. Porque eu acho que o realismo do QI é bastante difundido dentro desta comunidade. Bostrom escreveu que o QI é bom, mas imperfeito. Então eles meio que se inclinam para o realismo do QI.

Alguém se diz TESCREALista?

RU: Você observou que Marc Andreessen se identificou com esse bundle que você co-criou. Outras pessoas abraçaram diretamente o termo como uma identidade positiva que você conhece?

ÉT: Não, na verdade, não. Hanania reconhece isso ao argumentar que o “direito tecnológico” é um termo melhor. Ele disse que estávamos basicamente certos sobre o que são os fluxos, o que é o bundle, mas ‘direito tecnológico’ é um termo melhor. Não me surpreende que não haja mais pessoas a assumirem e a dizerem que se identificam como TESCREAL.

RUS: Talvez depois que isso correr no Mindplex haja um monte de pessoas decidindo que é quem elas são. Oh querida. O que fizemos?

Eugenia

RUS: Deixe-me tentar uma questão espinhosa: eugenia. Que tal intervir na linha germinal para prevenir doenças horríveis e coisas assim? Você acha que pode haver um uso legítimo para esse tipo de coisa?

ÉT: Sim. Penso que isso poderia ser admissível em determinadas circunstâncias. Quer dizer, eu tenho preocupações sobre os limites do que essa tecnologia será usada. Será usado apenas para o que intuitivamente chamaríamos de fins terapêuticos? A minha principal preocupação é que isso possa facilmente abrir a porta a uma abordagem de “melhoria”. Assim que você está falando sobre melhorias, há perguntas como: “Quais critérios você está usando para julgar se alguma modificação é melhor?” É aí que você entra na questão das “superclasses” sobre as quais Bostrom escreveu.

Muito disso é provavelmente capacitista. O que “aprimorar” significa para alguém como Bostrom pode ser completamente diferente do que eu poderia dizer. Certo?

RUS: Confesso que tive uma reação brusca na primeira vez que ouvi o termo capacitismo. As pessoas devem ser capazes. Geralmente, devemos ser a favor das habilidades e não entrar em um lugar onde as pessoas estão adorando suas partes quebradas, por assim dizer. Ao mesmo tempo, as pessoas devem ter o direito de escolher como querem ser. Mas estou desconfortável com a ideia de que as pessoas gostariam de manter o que a maioria das pessoas consideraria uma espécie de quebrantamento. E eu me pergunto: cadê a fila para isso?

ÉT: Minha sensação é que palavras como “quebrado” são termos normativos. Acho que ativistas dos direitos das pessoas com deficiência ou estudiosos da deficiência têm razão quando dizem: “há um número infinito de coisas que eu não posso fazer”. Eu não posso voar. A noção de deficiência, diriam alguns, é apenas uma construção social. Vivemos em uma sociedade que não é acomodada para alguém que não pode fazer algo que uma maioria estatística de outras pessoas pode fazer. Isso é o que é uma ‘deficiência’. Então, talvez, você conserte a sociedade, a deficiência vai embora mesmo que a incapacidade permaneça.

RUS: Como você pensaria sobre problemas físicos que tornam a vida mais difícil para um indivíduo, ou para as pessoas ao seu redor?

ÉT: Há dois aspectos nisso. Uma é a incapacidade e a outra é a sociedade em que se vive. Assim, você pode corrigir ou eliminar a deficiência melhorando a sociedade. E há um bom argumento de que muitas das inabilidades que classificamos como deficiências não seriam vistas como ruins. É apenas diferente. Há pessoas de diferentes alturas. Tem gente que não consegue andar. Acho que meu coração está cheio de muita empatia pelos estudiosos da deficiência – alguns dos quais são deficientes – argumentando que eles não gostariam de mudar. E sua visão de que não devemos almejar um mundo em que pessoas como eles não existam mais.

Techno Melancolia

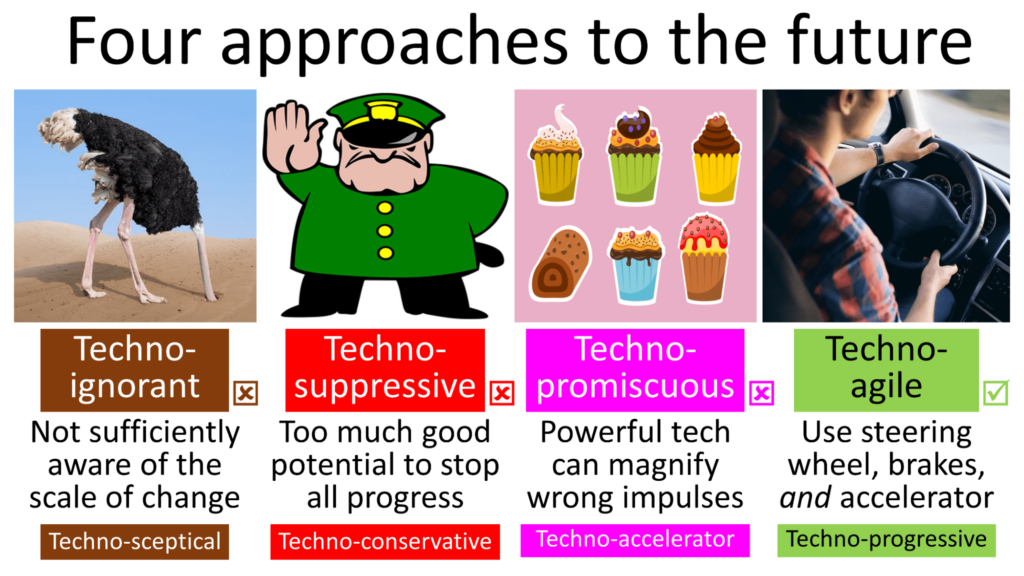

RUS: Precisamos nos preocupar com formas extremas de negativismo tecnológico? Por exemplo, a pessoa que não consegue andar sozinha vai contar com uma boa tecnologia para se locomover e, provavelmente, esperar por uma tecnologia ainda melhor. E há um movimento real em direção ao negativismo tecnológico extremo agora, claramente provocado em parte pelo tipo de pessoas TESCREAListas que você está trazendo à tona. Eu me pergunto se você está um pouco preocupado que possa haver uma reação exagerada, um tipo de movimento reacionário de tecnologia que é realmente prejudicial?

ÉT: Não tanto porque eu não vi muitas evidências, pelo menos como meu feed de mídia social.

RUS: Você não mora perto de São Francisco…

ÉT: Para simplificar, muitas das pessoas no meu círculo são a favor de uma boa tecnologia, não de uma má tecnologia. Talvez tecnologias de pequena escala, o que não significa baixa tecnologia. Assim, você pode ter tecnologias avançadas que permitiriam que alguém se locomovesse e não pudesse andar. Mas sem os megacorpos, e todo o controle e todo o risco que vem com isso.

.png)

.png)

.png)