Una etiqueta peligrosa

Imagina si dijera: “Algunos cristianos niegan la realidad de la evolución biológica, por lo tanto, todos los cristianos niegan la realidad de la evolución biológica”.

O que algunos musulmanes creen que los apóstatas deberían ser condenados a muerte, por lo tanto, todos los musulmanes comparten esa creencia.

O que algunos ateos (como Stalin y Mao, por ejemplo) causaron la muerte de millones de personas, por lo tanto, el ateísmo en sí mismo es una ideología asesina.

O, para acercarnos más a casa (para mí: crecí en Aberdeenshire, Escocia), dado que algunos escoceses son tacaños con el dinero, por lo tanto, todos los escoceses son tacaños con el dinero. (Dentro de Escocia en sí, ese estereotipo desagradable existe con un giro: supuestamente, todos los habitantes de Aberdeen son tacaños con el dinero).

En todos estos casos, dirías que es un etiquetado injustificado. La propagación de tales estereotipos es peligrosa. Obstaculiza un análisis más completo y una apreciación más profunda. Las personas en la vida real son mucho más variadas que eso. Toda comunidad tiene su diversidad.

Estoy igualmente sorprendido por otra instancia de etiquetado. Esto involucra el perezoso concepto de TESCREAL, un concepto que apareció en un artículo reciente aquí en Mindplex Magazine, titulado “TESCREALismo: ¿Se ha ido la clase gobernante del Silicon Valley a “Crazy Town”? Émile Torres en conversación con R.U. Sirius”.

Cuando leí el artículo, mi primer pensamiento fue: “Mindplex se ha ido a “Crazy Town”! “

El concepto de TESCREAL, que ha sido promocionado varias veces en varios lugares en los últimos meses, contrae un conjunto rico y diverso de ideas a una conclusión enormemente simplificada. Sugiere que los peores aspectos de las personas que sostienen cualquiera de las creencias incluidas en ese supuesto paquete de ideas se pueden atribuir, con confianza, a otras personas que sostienen solo algunas de estas ideas.

Peor aún, sugiere que toda la “clase gobernante” del Silicon Valley suscribe a lo peor de estas creencias.

Es como si eligiera al azar a un ateo e insistiera en que es igualmente asesino que Stalin o Mao.

O si eligiera al azar a un musulmán e insistiera en que desea la muerte de cada persona (apóstata) que creció en la fe musulmana y posteriormente abandonó esa fe.

En lugar de esa contracción conceptual, lo que el mundo necesita verdaderamente en la actualidad es una exploración de mente abierta de un amplio conjunto de ideas complejas y sutiles.

No la sed de sangre que parece motivar a los analistas del movimiento TESCREAL.

No la incitación al odio hacia los emprendedores y tecnólogos que están construyendo muchos productos notables en el Silicon Valley, personas que, sí, deben rendir cuentas por parte de lo que están haciendo, ¡pero que de ninguna manera son un grupo uniforme!

Soy una T pero no una L

Tomemos un ejemplo: yo.

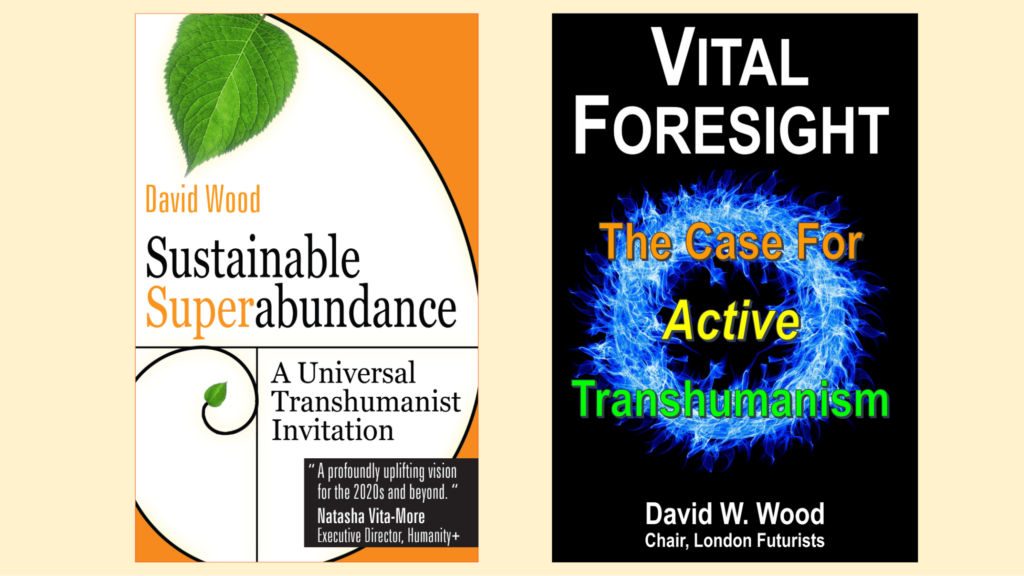

Me identifico públicamente como transhumanista, la ‘T’ de TESCREAL.

La palabra ‘transhumanista’ aparece en la portada de uno de mis libros, y la palabra relacionada ‘transhumanismo’ aparece en la portada de otro.

Al mismo tiempo, también he sido ejecutivo de tecnología. Estaba principalmente localizado en Londres, pero era responsable de supervisar al personal en la oficina de Symbian en Redwood City, en Silicon Valley. Juntos, imaginamos cómo los dispositivos de última generación llamados ‘teléfonos inteligentes’ podrían mejorar con el tiempo muchos aspectos de la vida de los usuarios. (Y también reflexionamos sobre al menos algunos posibles inconvenientes, incluyendo los riesgos de violaciones de seguridad y privacidad, razón por la cual defendí la nueva reconfiguración de ‘seguridad de plataforma’ del kernel OS Symbian. Pero me desvío del tema).

Dado que soy ‘T’, ¿significa eso que también soy ESCREAL?

Examinemos esa ‘L’ final. Largoplacismo. Esta letra es fundamental para muchos de los argumentos presentados por los analistas del movimiento TESCREAL.

‘Largoplacismo” es la creencia de que las necesidades de potencialmente vastos números de personas aún no nacidas (y no concebidas) en futuras generaciones pueden primar las necesidades de las personas que viven actualmente.

Bueno, yo no adhiero al “largoplacismo”. No guía mis decisiones.

Me motiva la posibilidad de que la tecnología mejore enormemente la vida de todos alrededor del mundo que viven hoy. Y por la necesidad de anticipar y prevenir posibles catástrofes.

Con “catástrofe”, me refiero a cualquier evento que mate a grandes cantidades de personas que están vivas actualmente.

Las muertes del 100% de los que viven hoy aniquilarán el futuro de la humanidad, pero las muertes de ‘solo’ el 90% de las personas no lo harán. A los largoplacistas les gusta señalar esto, y aunque puede ser teóricamente correcto, no proporciona ninguna justificación para ignorar las necesidades de las personas actuales, para aumentar la probabilidad de que nazcan mayores cantidades de personas en el futuro.

Algunas personas han dicho que han sido persuadidas por el argumento largoplacista. Pero sospecho que eso es solo una pequeña minoría de personas más bien intelectuales. Mi experiencia con personas en Silicon Valley y con otros que están diseñando y construyendo nuevas tecnologías es que estas consideraciones abstractas largoplacistas no guían sus decisiones diarias. Para nada.

Los conceptos son complicados

Aquí hay un punto más amplio que debe señalarse. Conceptos como ‘transhumanismo’ y ‘largoplacismo’ encarnan una rica variedad.

Lo mismo ocurre con todos los demás componentes del supuesto paquete TESCREAL: E para Extropianismo, S para Singularitarianismo, C para Cosmismo, R para Racionalismo y EA para Altruismo Efectivo.

En cada caso, debemos evitar el contraísmo, pensar que si has escuchado a una persona que defiende esa filosofía expresar una opinión, entonces puedes deducir lo que piensan sobre todos los demás asuntos. En la práctica, las personas son más complicadas, y las ideas son más complicadas.

Según lo veo, partes de cada una de las filosofías T, E, S, C, R y EA merecen una amplia atención y apoyo. Pero si eres hostil y buscas un poco, puedes encontrar fácilmente a personas, dentro de las comunidades alrededor de cada uno de estos términos, que han dicho algo despreciable o aterrador. Y luego puedes etiquetar (perezosamente) a todos los demás en esa comunidad con ese mismo rasgo indeseado. (“Viste a uno; ¡los viste a todos!”)

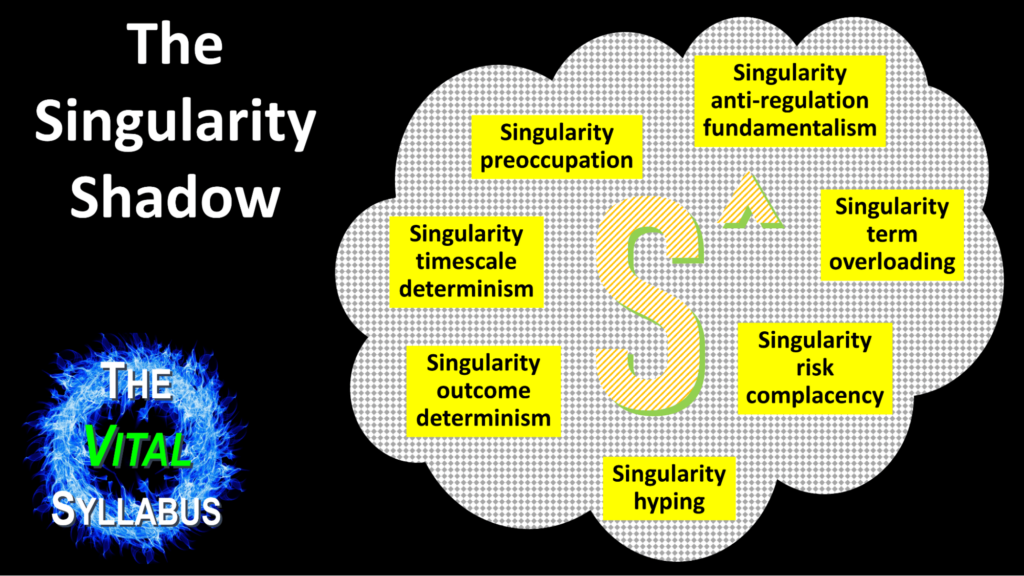

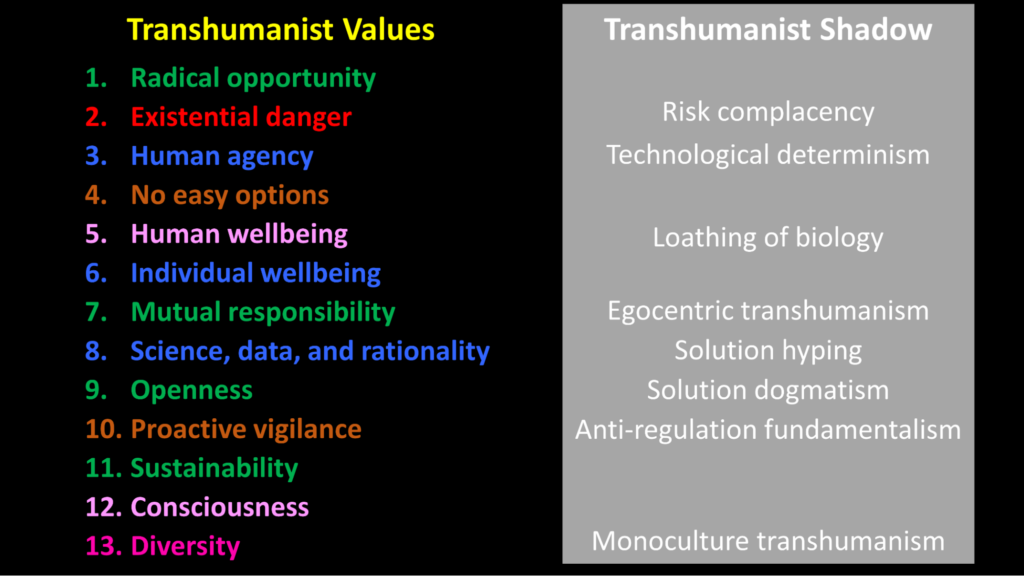

Estas comunidades extendidas sí tienen algunas personas con rasgos indeseados. De hecho, tanto T como S han atraído lo que yo llamo una ‘sombra’: un conjunto de creencias y actitudes asociadas que son desviaciones de las valiosas ideas centrales de la filosofía. Aquí hay una imagen que uso de la sombra de la Singularidad:

Y aquí tienes una imagen de la sombra transhumanista:

(En ambos casos, puedes hacer clic en los enlaces de la descripción para ver un video que ofrece un análisis más completo.)

Como puedes ver, los rasgos en la sombra transhumanista surgen cuando las personas no logran mantener lo que he enumerado como “valores transhumanistas”.

La existencia de estas sombras es innegable y desafortunada. Las creencias y actitudes en ellas pueden disuadir a los observadores independientes de tomar en serio el fundamento de estas filosofías.

En ese caso, podrías preguntar, ¿por qué persistir con los términos fundamentales “transhumanismo” y “singularidad”? ¡Porque hay mensajes positivos críticamente importantes en ambas filosofías! Pasemos a estos a continuación.

La previsión más vital

Aquí mi resumen de 33 palabras de la previsión más vital que puedo ofrecer:

Inminentes olas de cambio tecnológico están listas para traer consigo tanto la destrucción global como una abundancia sostenible paradisíaca, dependiendo del oportuno fortalecimiento de la visión transhumanista, la política transhumanista y la educación transhumanista.

Vamos a revisarlo de nuevo, más despacio esta vez.

Primero lo primero. Los cambios tecnológicos en las próximas décadas pondrán un inmenso poder en las manos de miles de millones de personas. En lugar de centrarnos en las implicaciones de la tecnología actual, por significativas que sean, debemos dirigir nuestra atención a las aún mayores implicaciones de la tecnología del futuro cercano.

En segundo lugar, estas tecnologías amplificarán los riesgos de desastres humanitarios. Si ya nos preocupan estos riesgos hoy (como deberíamos), deberíamos estar aún más preocupados por cómo se desarrollarán en el futuro cercano.

En tercer lugar, el mismo conjunto de tecnologías, manejado con más sabiduría y dirigido de manera más enérgica, puede dar como resultado un resultado muy diferente: una superabundancia sostenible de energía limpia, nutrición saludable, bienes materiales, excelente salud, inteligencia integral, creatividad dinámica y una colaboración profunda.

Cuarto, la influencia más significativa en la realización de cualquiera de estos resultados es la adopción generalizada del transhumanismo. Esto implica a su vez tres actividades:

- Abogar por la filosofía transhumanista como una cosmovisión integral que aliente e inspire a todos a unirse al próximo salto evolutivo en la gran escalera evolutiva de la vida: podemos y debemos desarrollarnos a niveles más altos, física, mental y socialmente, utilizando la ciencia, la tecnología y métodos racionales.

- Extender las ideas transhumanistas a actividades políticas del mundo real, para contrarrestar tendencias muy destructivas en ese campo.

- Apoyar las iniciativas anteriores: una transformación del mundo de la educación, para proporcionar a todos habilidades adaptadas a las circunstancias muy diferentes del futuro cercano, en lugar de las necesidades del pasado.

Finalmente, más allá de la trascendental transición que acabo de describir está el potencial de un cambio aún más grande, en el cual la tecnología avanza aún más rápido, con la llegada de una inteligencia artificial que tenga la capacidad de auto-mejorarse con niveles sobrehumanos de capacidad en todos los aspectos del pensamiento.

Eso nos lleva al tema de la Singularidad.

La Singularidad es el punto en el tiempo en el cual las inteligencias artificiales podrían, potencialmente, tomar el control del mundo de los humanos. El hecho de que la Singularidad podría ocurrir en unas pocas décadas merece ser proclamado a los cuatro vientos. Eso es lo que hago, parte del tiempo. Eso me convierte en un singularitario.

Pero no significa que yo, ni otros que también intentan concientizar sobre esta posibilidad, caigamos en ninguno de los rasgos de la Sombra de la Singularidad. No significa, por ejemplo, que seamos complacientes acerca de los riesgos, o que todos pensemos que es básicamente inevitable que la Singularidad será beneficiosa para la humanidad.

Así que, el Singularitarianismo (S) no es el problema. El Transhumanismo (T) no es el problema. Tampoco, por cierto, el problema radica en las creencias fundamentales de las partes E, C, R, o EA del supuesto conjunto TESCREAL. El problema radica en otro lugar.

Lo que debería preocuparnos no es TESCREAL, sino CASHAP

En lugar de obsesionarnos con una supuesta toma de control de Silicon Valley por parte de TESCREAL, aquí está en lo que deberíamos estar realmente preocupados: CASHAP.

C es para contractivismo: la tendencia a fusionar ideas que no necesariamente deberían ir juntas, a pasar por alto variaciones y complejidades en las personas y en las ideas, y a insistir en que los valores fundamentales de un grupo pueden ser denigrados solo porque algunos miembros periféricos tienen creencias o actitudes desagradables.

(Nota: mientras que los seguidores del concepto TESCREAL son culpables de contractivismo, mi concepto alternativo de CASHAP es diferente. No estoy sugiriendo que las ideas en él siempre pertenezcan juntas. Cada una de las ideas individuales que componen CASHAP son perjudiciales).

A es para aceleracionismo: el deseo de ver nuevas tecnologías desarrolladas y desplegadas lo más rápido posible, bajo la creencia irresponsable de que cualquier defecto encontrado en el camino siempre se puede solucionar fácilmente en el proceso (“moverse rápido y romper cosas”).

S es para sucesionismo: la idea de que si la inteligencia artificial superinteligente desplaza a la humanidad del control del planeta, esa sucesión debería ser automáticamente bienvenida como parte del gran proceso evolutivo, independientemente de lo que suceda con los humanos en el proceso, sin importar si las IA tienen conciencia, y de hecho, sin importar si estas IA se autodestruyen a sí mismas y al planeta.

H es para exageración: creer en ideas demasiado fácilmente porque encajan en tu visión preexistente del mundo, en lugar de utilizar el pensamiento crítico.

AP es para antipolítica: creer que la política siempre empeora las cosas, obstaculizando la innovación y la creatividad. En realidad, la buena política ha sido increíblemente importante para mejorar la condición humana.

Conclusión

Concluiré este artículo enfatizando las características positivas opuestas a los rasgos indeseables de CASHAP que acabo de enumerar.

En lugar de caer en el contractivismo, debemos estar listos para expandir nuestro pensamiento y dejar que nuestras ideas sean desafiadas. Debemos estar preparados para encontrar ideas importantes en lugares inesperados, incluso entre personas con las que tengamos muchas desavenencias. Debemos estar listos para poner en espera nuestras reacciones emocionales de vez en cuando, ya que nuestros instintos previos de ninguna manera son una guía infalible para los tiempos turbulentos que se avecinan.

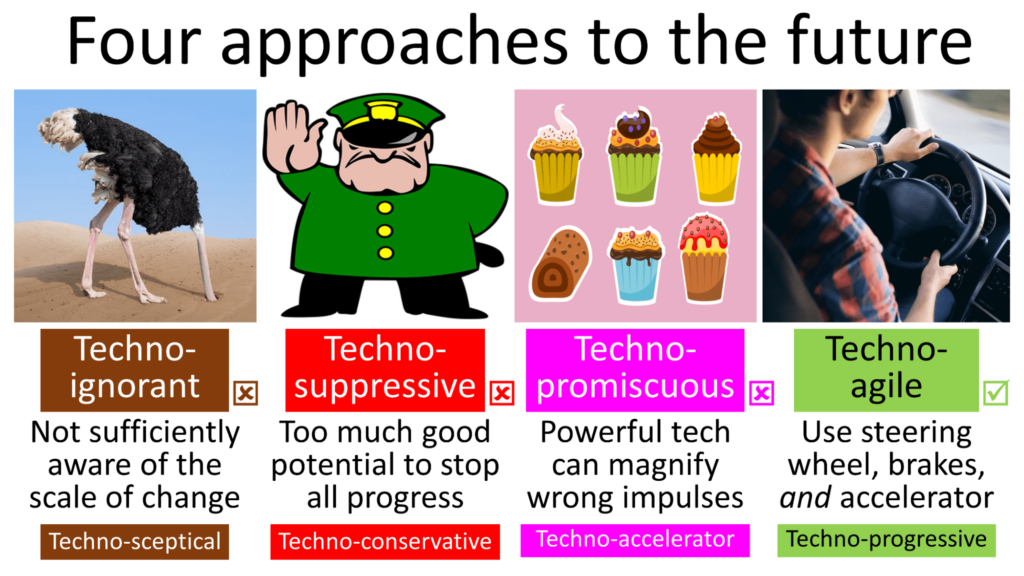

En lugar de aceleracionismo, debemos utilizar un conjunto de herramientas más sofisticado: a veces frenando, a veces acelerando y también dirigiendo mucho. Eso es lo que he llamado el enfoque tecno-progresista (o tecno-ágil) hacia el futuro.

En lugar de caer en el sucesionismo, deberíamos abrazar el transhumanismo: podemos y debemos elevar a los humanos de hoy hacia niveles más altos de salud, vitalidad, libertad, creatividad, inteligencia, conciencia, felicidad, colaboración y goce. Y antes de presionar cualquier botón que pueda llevar a la humanidad a ser desplazada por inteligencias artificiales superinteligentes que podrían poner fin a nuestro florecimiento, ¡necesitamos investigar cuidadosamente una gran cantidad de problemas!

En lugar de la exageración, debemos reafirmar nuestro compromiso con el pensamiento crítico, siendo más conscientes de cualquier tendencia a llegar a conclusiones falsas o dar demasiado peso a conclusiones que son sólo tentativas. De hecho, ese es el mensaje central de la parte R (racionalismo) de TESCREAL, lo que hace aún más “Crazy Town” que el R sea despreciado por esa simplificación contractiva.

Debemos aclarar y defender lo que se ha llamado “el camino estrecho” (o a veces simplemente “política futura“) —que se encuentra entre estados que tienen muy poco poder (dejando a las sociedades como rehenes de cánceres destructivos que pueden crecer en nuestro medio) y tener demasiado poder (sin contrapeso de una “sociedad fuerte”).

.png)

.png)

.png)